GETTY IMAGES

Can we fix AI’s evaluation crisis?

신뢰 잃어가는 AI 평가, 지금 이대로 괜찮을까

AI 성능을 평가하는 기존 벤치마크가 한계에 봉착했다. 이를 극복하기 위한 새로운 실험과 논의가 이어지고 있다.

기술 전문 기자로 일하다 보면 “딥시크가 정말 챗GPT보다 좋은가요?”라든지 “앤트로픽 모델도 쓸만해요?” 같은 질문을 자주 받는다. 하지만 이런 질문에 제대로 답하려면 1시간짜리 강연으로도 모자랄 정도라, 보통은 “각자 장점이 있다”는 식으로 에둘러 답하곤 한다.

문제는 ‘좋다’는 기준 자체가 주관적이라는 데 있다. 누군가는 정확도를, 또 누군가는 대화의 자연스러움이나 창의성을 ‘좋다’는 데 대한 기준으로 삼는다. 이렇게 기준이 제각각이다 보니 어떤 모델이 더 좋다고 단정하기는 어렵다. 결국 “이 모델이 좋은가요?”라는 질문은 매우 복잡하고 기술적인 의미가 담긴 질문이나 다름이 없다.

지금까지 우리는 주로 ‘벤치마크 테스트’에 의존해 이 질문에 대답해왔다. 정해진 문제를 제시하고, AI가 얼마나 정확하게 답을 밎히는지를 수치로 평가하는 방식이다. 하지만 미국 대학 입시에 활용되는 SAT 시험처럼 이런 방식은 모델의 진짜 실력을 제대로 보여주지 못하는 경우도 많다.

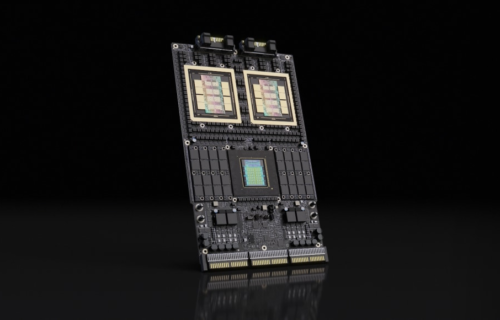

최근 들어 새로운 AI 모델이 거의 매주 출시되고 있다. 기업들은 매번 이전보다 높은 벤치마크 점수를 앞세워 최신 모델의 개선된 성능을 강조한다. 점수만 봐서는 기술이 꾸준히 진화하는 것 같지만, 실상은 그리 단순하지 않다.