[인터뷰] “어? 맞장구도 치네!”… AI, 이젠 진짜 ‘사람처럼’ 말한다 – 서울대 김건희 교수

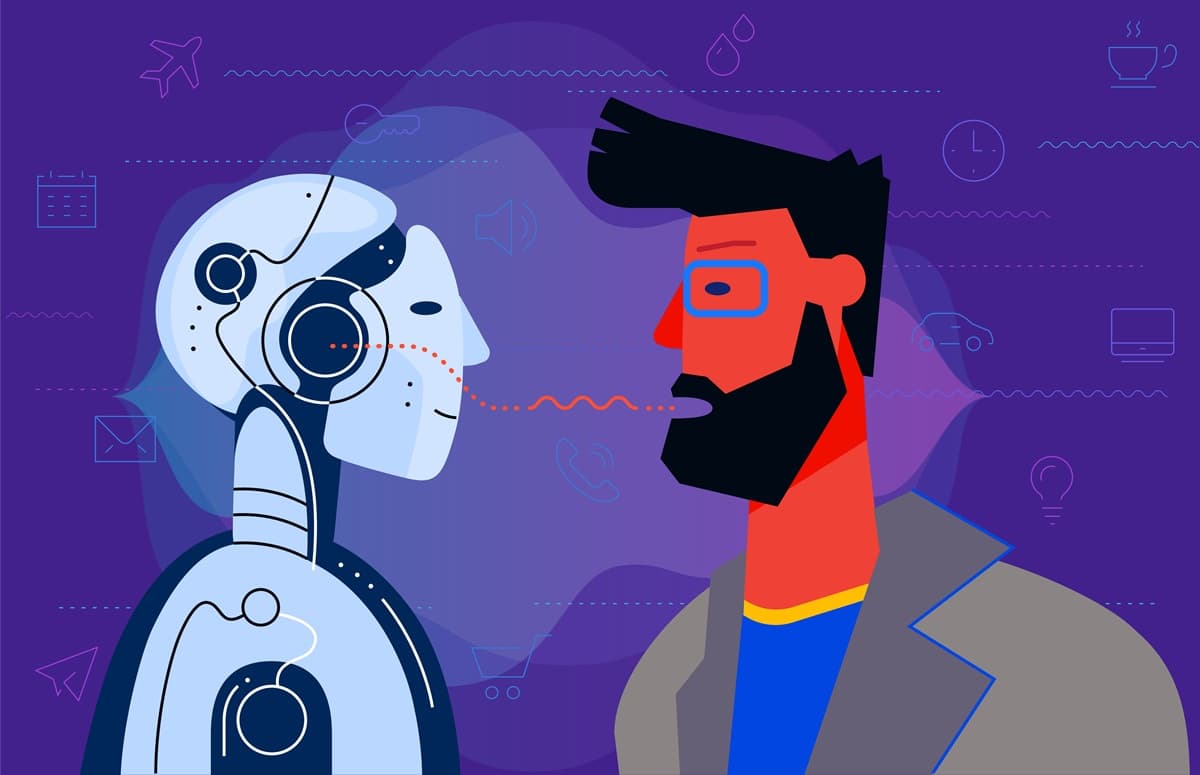

최근 AI 기술이 빠르게 진화하면서, 사람처럼 자연스럽게 대화하는 AI가 새로운 연구 주제로 떠오르고 있다. 단순히 질문에 답을 하는 수준을 넘어, 대화 중 상대의 반응을 실시간으로 감지하고, 맥락에 맞춰 말을 조절하는 기술이 개발되고 있다. 특히 음성과 표정, 속도, 추임새까지 반영하는 방식으로 인간 대화의 복잡함을 모방하려는 시도가 활발하다.

서울대학교 컴퓨터공학과 김건희 교수도 이 분야에 주목하고 있다. 김 교수팀은 최근 사람의 말버릇, 추임새, 끼어들기 등 실제 대화에서 나타나는 행동을 AI가 이해하고 재현하는 음성 대화 생성 기술을 개발했다.

김 교수팀은 이 같은 기술을 개발하기 위해 세계 최대 규모의 대화 행동 기반 음성 데이터셋인 ‘Behavior-SD’를 구축했다. 약 10만 개의 대화 패턴과 2000시간 분량의 실제 음성 데이터를 수집해서 사람들이 대화 중 사용하는 말버릇, 추임새, 끼어들기, 감정 표현 등 세밀한 대화 행동까지 주석 처리했다. 기존 AI 모델이 정확한 문장을 인식하고 전달하는 데 집중했던 것과 달리, 이 데이터셋은 실제 사람 간의 대화를 보다 정교하게 재현할 수 있도록 설계됐다.

이 데이터를 바탕으로 개발된 ‘BeDLM(Behaviorally Aware Spoken Dialogue Model)’은 대형언어모델(LLM) 기반으로 대화 상대의 행동 패턴까지 고려해 대사를 생성하는 것이 특징이다. 이 모델은 상대방의 말하는 습관과 대화 흐름을 실시간으로 반영해 추임새를 넣거나 적절히 끼어들며, 기존 AI 대화 시스템이 보여주던 어색한 말투를 크게 개선했다. 덕분에 실제 사람처럼 자연스럽고 유연하게 대화를 이어가는 AI 구현이 가능해졌다.

이 연구는 미국 뉴멕시코주 앨버커키에서 열린 북미컴퓨터언어학회(NAACL) 2025에서 발표됐으며, 음성 처리 및 음성 언어 이해 분야 최고 논문상인 Senior Area Chair Award를 수상하는 성과를 거뒀다.

서울대학교 김건희 교수를 만나 이 기술의 핵심과 AI 대화의 미래를 들어봤다.

AI, 눈치껏 말 끊고 화제 바꾼다

김 교수는 기존 AI 대화 시스템이 아직 사람처럼 자연스럽지 못하다고 지적했다. 그는 “원활한 커뮤니케이션을 위해서는 AI가 마치 사람과 같은 방식으로 음성 대화를 해야 한다”고 강조했다.

현재 AI는 사용자가 말을 마치면 AI가 대답하는 방식으로 작동한다. 그러나 실제 사람 간의 대화는 훨씬 복잡하다. 김 교수는 “내가 말을 하는 도중에도 상대방이 반응을 보이면 잠시 멈추거나 화제를 바꾸고, 필요에 따라 말을 끊고 다시 이어가기도 한다”고 설명했다. 이처럼 대화는 끊임없이 상대의 반응을 읽으며 조절된다. 김 교수는 “사람들 간의 대화는 매우 유연하다. 최근 LLM이 대화 내용을 생성하는 능력은 상당히 발전했지만, 이런 자연스러운 흐름을 구현하는 것은 여전히 어렵다”며 “그래서 말버릇, 추임새, 말 속도의 변화 등을 반영하는 대화 모델을 개발하고 있다”고 덧붙였다.

이를 위해 연구팀은 기존에는 존재하지 않던 새로운 데이터셋을 만들어야 했다. 김 교수는 “그동안 한 사람이 말하면 상대가 대답하는 데이터는 있었지만, 상대가 말하는 도중 짧게 반응하는 데이터를 찾기 어려워 새로 만들어야 했다”고 말했다. 데이터 구축 과정은 상당히 복잡했다. 김 교수는 “먼저 기존 대화를 기반으로 어느 시점에 반응을 넣을지 예측하고, 긍정적 반응이나 부정적 반응, 중간에 질문하는 반응 등을 추가해 데이터를 변형했다”고 설명했다.

AI가 예측한 데이터라 하더라도 최종 검증은 사람이 담당한다. AI가 어느 시점에 반응해야 하는지 높은 정확도로 예측해도 10% 정도는 오류가 발생하기 때문에 사람이 직접 확인하고 보정하는 과정이 필요하기 때문이다. 이처럼 자연스러운 대화를 가능하게 하려면 결국 대량의 고품질 데이터가 필수적이다. 김 교수는 “지금 AI 분야에서 가장 중요한 것은 양질의 데이터”라고 강조했다. 과거에는 인터넷에서 데이터를 수집해 사용할 수 있었지만, 현재는 의료, 국방 등과 같은 특정 영역에 대한 고도의 전문화된 데이터가 필요하다. 그는 “AI가 한단계 더 도약하기 위해서는 정말 큰 비용을 들여 각각의 영역에 맞춰진 고품질 데이터를 확보해야 하는 시점에 도달했다”고 설명했다.

김 교수는 연구 과정에서 가장 인상 깊었던 순간으로 BeDLM 모델이 처음으로 자연스럽게 추임새를 넣고 끼어드는 대화를 만들어낸 때를 꼽았다. 그는 “단순히 텍스트를 음성으로 바꾸는 것이 아니라, 대화의 맥락과 감정을 반영해 살아있는 듯한 대화를 만들어내는 모습을 보고 기술의 가능성을 실감했다”고 말했다.

이 기술을 구현하는 과정은 순탄치 않았다. 김 교수는 “두 사람의 발화가 겹치거나 끼어들기가 포함된 대화는 기존 LLM으로는 자연스럽게 생성하기 어려웠고, 문맥을 반영하는 데 한계가 있었다”고 설명했다. 이를 해결하기 위해 팀은 발화를 시계열로 직렬화하면서도 끼어들기와 겹침을 효과적으로 표현할 수 있도록 ‘Streamlined unit’ 구조를 고안했다. 이는 두 화자의 발화를 각각 분리된 채널로 처리하는 기존의 방식에서 벗어나 두 화자의 대화 내용을 하나의 시퀀스로 정렬해 겹침 발화나 백채널, 침묵 등을 모델링하는 방식이다. 그는 “새로운 방식이라 처음에는 팀원들 간 의견 차이도 있었지만 최종 결과를 확인했을 때 모두 큰 성취감을 느꼈다”고 회상했다.

단 10문장으로 완성되는 ‘가짜 내 목소리’

현재 김 교수는 이 기술이 상용화에 한 걸음 더 다가섰다고 보고 있다. 그는 “지금 GPT도 대화는 잘 따라오지만, 사람처럼 자연스럽게 말하는 느낌은 아직 부족하나 현재의 발전 속도를 감안하면 1~2년 내에는 사람과 거의 비슷한 수준의 자연스러운 대화가 가능해질 것으로 예상한다”고 말했다.

다만, 기술 발전의 이면에는 악용 가능성도 있다. 김 교수는 “10문장 정도 녹음하면 누구의 목소리라도 복제할 수 있다. 전화 통화 수준에서는 가족조차 속일 수 있는 수준이다. 사람은 시각에 많이 의존하기 때문에 목소리만 듣는 통화에서는 오히려 더 쉽게 속을 수도 있다”고 우려를 나타냈다.

그러나 이렇게 발전한 기술은 상담이나 돌봄 분야에서는 오히려 긍정적인 가능성을 열어준다. 김 교수는 “사람들은 진실된 대화를 자주 하지 않지만, AI는 지치지 않고 항상 친절하게 대응할 수 있다. AI 친구 5명과 함께 사는 시대도 머지않았다”고 덧붙였다.

AI 기술 발전 속도는 결국 투자 여력에 좌우된다고 김 교수는 주장했다. 그는 “미국과 중국이 앞서가는 이유는 막대한 자본을 투입하기 때문이다. 한국도 인재 수준은 뒤지지 않지만, 대규모 투자가 부족하다”고 지적했다.

앞으로 김 교수는 멀티모달 대화형 AI에 도전하고 싶다는 계획을 밝혔다. 그는 “음성뿐 아니라 표정, 제스처 등 시각 정보를 통합해 인간 대화를 더욱 정교하게 모방하는 AI를 개발하고 싶다”면서 “사용자의 감정을 정확히 인지해 대화 방식을 조절하는 감성 대화 AI 연구도 깊이 있게 진행하고 싶다”고 말했다.

김 교수는 끝으로 “AI는 단순한 기술이 아니라 인간과 기업의 소통 방식을 바꾸는 커다란 흐름이다. 변화를 얼마나 빠르게 준비하느냐가 경쟁력을 결정할 것”이라고 강조했다.

김건희 교수는 KAIST에서 기계공학 학·석사를 마친 후, 카네기멜론대학교 로봇공학 석사 및 컴퓨터과학 박사를 취득했으며, 이후 한국과학기술연구원(KIST) 지능로봇연구센터와 디즈니리서치에서 연구원으로 활약했다. 2015년 서울대학교 컴퓨터공학부에 교수로 부임한 이래, 컴퓨터 비전, 머신러닝, 자연어처리 분야에서 매년 7~11편의 국제 학회 논문을 발표해 왔다. 최근에는 세계 최대 규모의 대화 행동 기반 음성 데이터셋 ‘Behavior-SD’를 구축하고, 이를 바탕으로 한 AI 대화 모델 ‘BeDLM’을 개발해 국제학회에서 최고 논문상을 수상하는 등 주목할 만한 성과를 거두고 있다.