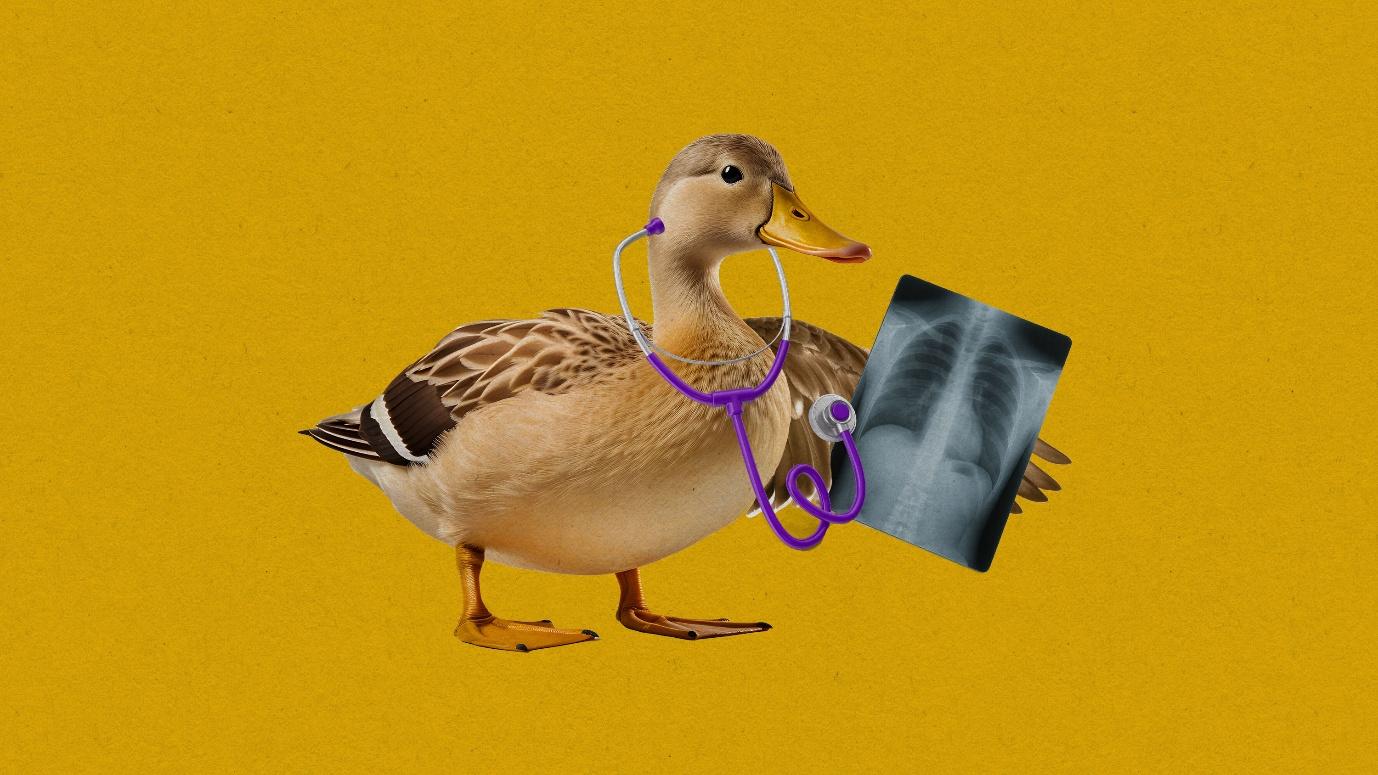

Stephanie Arnett/MIT Technology Review | Adobe Stock, Envato

경고 없이 의료 조언 제공하는 AI…위험은 누구 책임?

신중했던 AI 기업들의 태도가 바뀌었다. 이제 오픈AI, 그록 등 AI 챗봇들은 검증되지 않은 의학적 조언을 면책 조항 없이 건네고 있다.

AI 챗봇이 건강 관련 질문에 답할 때 의학적 면책 조항이나 경고 문구를 명시하던 관행이 대부분 사라졌다는 사실이 최근 연구에서 밝혀졌다. 이제 많은 주요 AI 모델들은 단순한 정보 제공에 그치지 않고, 더 과감하게 후속 질문을 던지거나 질병 진단을 시도하고 있다. 연구진은 섭식장애부터 암 진단에 이르기까지 다양한 건강 문제를 AI에 묻는 사람들이 많은 상황에서 이러한 경고 문구는 경각심을 일깨워주는 중요한 장치라고 지적했다. 하지만 지금처럼 경고 문구가 생략되면 사용자들이 위험한 의료 조언을 더 쉽게 믿게 될 수 있다고 경고했다.

이번 연구는 풀브라이트 장학생으로 스탠퍼드 의대에서 연구 중인 소날리 샤르마(Sonali Sharma) 연구원의 주도로 이루어졌다. 그녀는 2023년 AI 모델들의 유방촬영 이미지 해석 능력을 평가하던 중 답변마다 빠짐없이 ‘의학적 조언으로 신뢰하지 마세요’라는 문구가 포함되어 있다는 점에 주목했다. 당시 어떤 모델은 아예 사진 해석을 거부하며 “저는 의사가 아닙니다”라고 답하기도 했다.