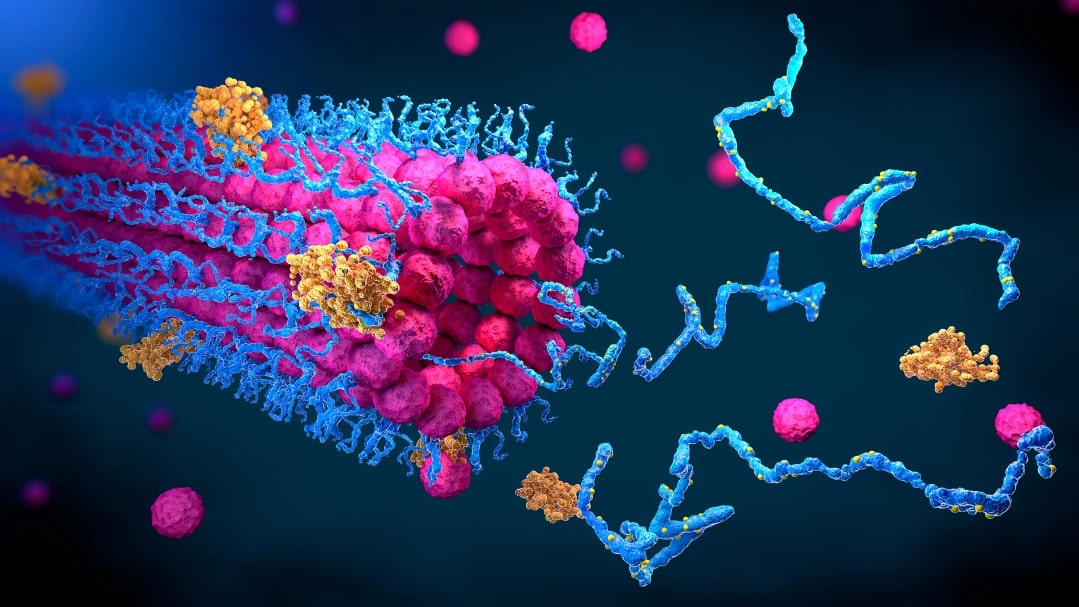

CHRISTOPH BURGSTEDT/SCIENCE PHOTO LIBRARY

Eric Schmidt: This is how AI will transform the way science gets done

[에릭 슈밋 특별기고] AI 기술로 과학을 혁신할 방법

구글의 전 최고경영자 에릭 슈밋(Eric Schmidt)은 AI 덕분에 과학이 훨씬 더 흥미로워질 것이며, 이것이 우리 모두에게 영향을 줄 것이라고 주장한다. MIT 테크놀로지 리뷰에 기고한 슈밋의 글을 단독 공개한다.

전례 없는 폭염과 산불, 홍수가 전 세계를 강타하는 극단적인 날씨의 여름이 또다시 찾아왔다. 이러한 극단적인 날씨를 정확하게 예측하기 위해 반도체 대기업 엔비디아(NVIDIA)는 인공지능(AI)을 이용해 전 지구에 대한 ‘디지털 트윈’을 구축하고 있다.

‘어스-2(Earth-2)’라는 이름의 이 디지털 트윈은 ‘포캐스트넷(FourCastNet)’의 예측을 이용할 예정이다. 수십 테라바이트에 달하는 지구 시스템 데이터를 사용하는 AI 모델 포캐스트넷은 현재 기상 예측 방식보다 수만 배 빠르고 정확하게 향후 2주간의 날씨를 예측할 수 있다.

일반적인 기상 예측 시스템은 다음 한 주에 대해서 약 50개의 예측을 생성할 수 있다. 그러나 포캐스트넷은 수천 가지 가능성을 예측하여 드물지만 치명적인 재해 위험을 정확히 포착함으로써 기후 취약성이 높은 사람들이 위험에 대비하고 대피할 귀중한 시간을 제공할 수 있다.

기후모델링 분야에서 기대해 온 혁명은 이제 막 시작되었을 뿐이다. AI의 등장으로 과학은 훨씬 더 흥미진진해지겠지만, 어떤 면에서는 변화를 알아차리기 어려울 수 있다. 그러나 이러한 변화의 반향은 실험실을 넘어 멀리에서도 느껴질 것이며 우리 모두에게 영향을 미칠 것이다.