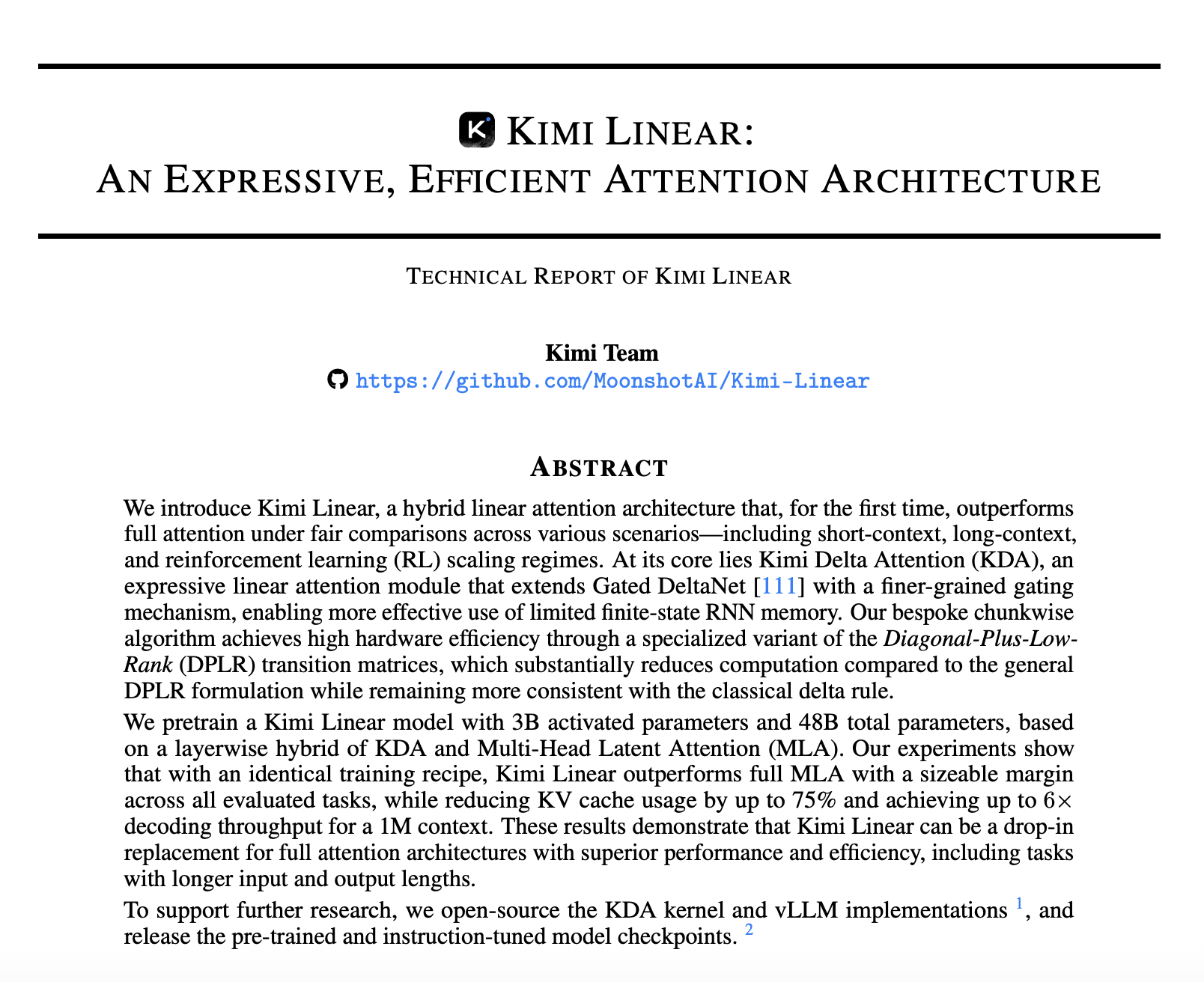

2017년 구글의 <주의가 전부다(Attention Is All You Need)> 논문이 트랜스포머 구조를 제시하며 대형언어모델(LLM) 시대의 시작을 알렸다면, 2025년 11월 1일 중국 스타트업 문샷 AI가발표한 <키미 리니어(Kimi Linear)>는 AI 에이전트 시대의 기술적 대전환을 보여주는 논문으로 기록될 전망이다.

<키미 리니어> 논문은 AI 모델 설계 패러다임 자체를 바꿨다는 점에서 의미가 크다. 지금까지의 트랜스포머 기반 LLM은 모든 정보를 동일한 방식으로 처리하는 ‘풀 어텐션(full attention)’ 구조의 제약에서 벗어나지 못했다. 반면 키미 리니어 모델은 중요한 정보만 선택적으로 기억하고 나머지는 효율적으로 잊는 채널별 망각 게이트((channel-wise gating) 구조를 도입해 이를 하이브리드 방식으로 구현함으로써 속도와 성능을 동시에 극대화했다.

그 결과 100만 개 단어(토큰)를 생성할 때, 구글이 제시한 트랜스포머 구조 기반의 기존 풀 어텐션 모델보다 6배 빠르고 메모리 사용량은 최대 75% 적다. 이는 장문 처리와 에이전트 운영의 효율뿐만 아니라, 모델이 정보를 저장하고 활용하는 방식의 변화를 보여준다.

논문이 던지는 질문은 ‘앞으로의 AI가 어떤 구조로 진화할 것인가’이다. 이는 본문에서 살펴볼 논의의 출발점이기도 하다.

트랜스포머의 성공 그리고 한계