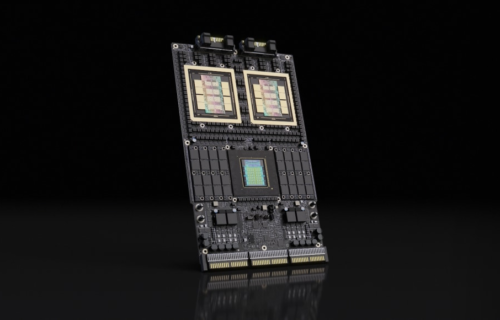

추론 시대를 위한 구글 TPU, 아이언우드

구글의 TPU를 구매하려는 메타의 움직임이 글로벌 AI 업계에 파장을 일으키고 있다. 이는 단순한 칩 구매를 넘어 AI 인프라가 어디로 향하고 있는지, 앞으로 어떤 구조가 산업의 표준이 될지, 그리고 왜 지금 이 변화가 시작되는지를 보여주는 사례가 될 전망이다. 외신 보도를 종합해 보면, 메타는 현재 수십 억 달러 규모의 구글 TPU 도입을 위한 최종 협상을 진행 중이다. 현재 진행 중인 협상에는 메타가 2026년 구글 클라우드 TPU를 임대한 후 2027년 도입하는 내용이 포함된 것으로 전해졌다.

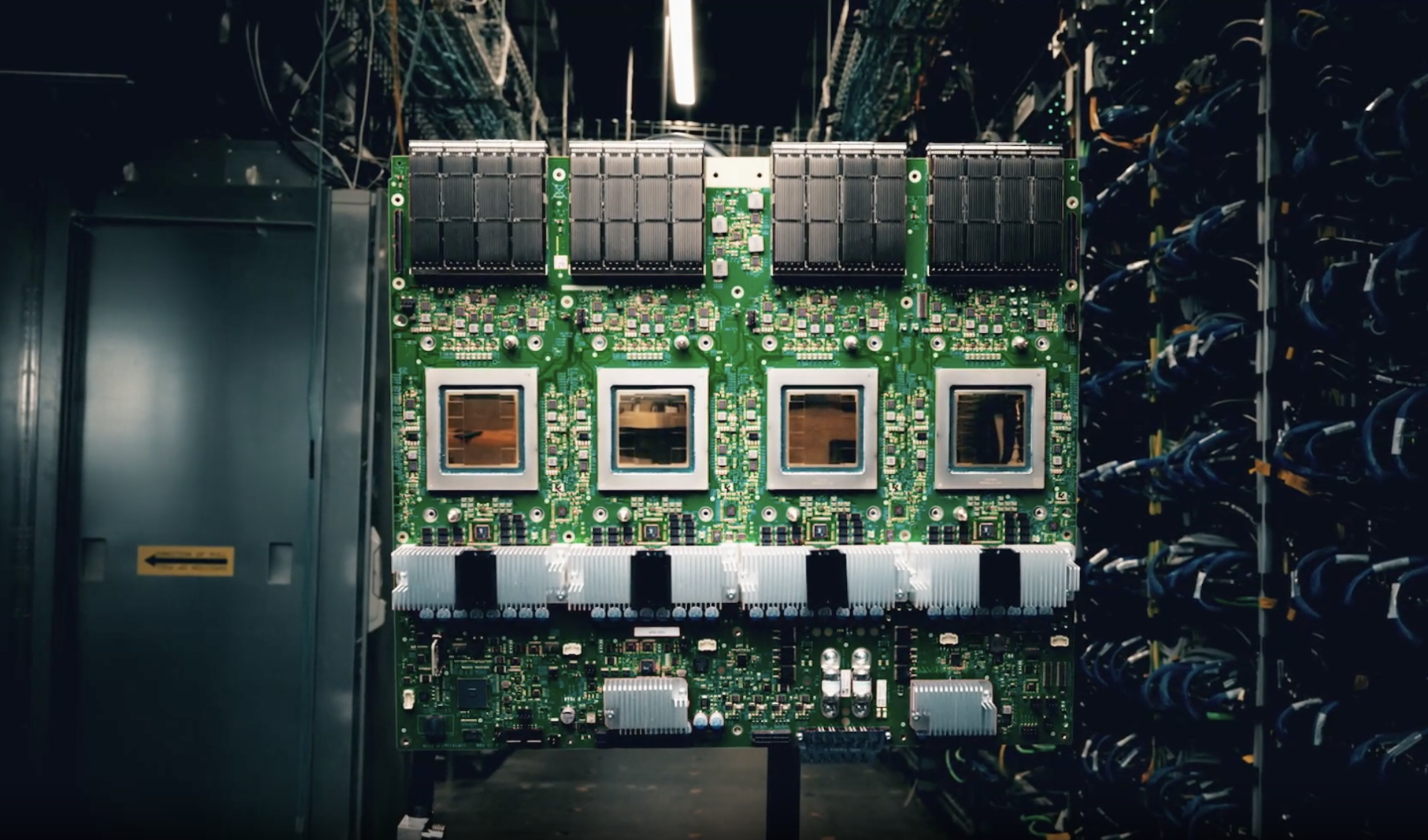

메타가 TPU를 검토하는 이유는 GPU를 대체할 새로운 반도체를 찾기 위해서가 아니다. TPU는 ‘칩 → 클라우드 → AI 모델 → 실제 서비스’가 하나의 흐름처럼 이어지는 구글의 수직통합 구조의 중심에 놓여 있다. 구글은 TPU를 직접 설계하고 자사 데이터센터에 배치해 제미나이·검색·유튜브·워크스페이스 서비스에 적용해왔다.

이 구조는 기존 GPU 생태계와 근본적으로 다르다. GPU는 칩을 구매한 뒤 기업이 직접 서버를 구성하고, 학습 환경을 만들어 서비스 운영 비용을 관리해야 했다. 반면 TPU는 처음 설계될 때부터 대규모 모델을 학습하고 곧바로 서비스에 적용한다. 하드웨어와 클라우드, 소프트웨어가 하나의 설계 구도 아래 결합되어 있다.

메타가 TPU 도입을 검토한다는 것은 회사의 학습 방식, 서비스 출시 속도, 운영 비용, AI 전략의 철학까지 다시 설계한다는 것을 의미한다.