MIT 테크놀로지 리뷰

Geoffrey Hinton talks about the “existential threat” of AI

제프리 힌턴, AI의 ‘실존적 위협’을 말하다

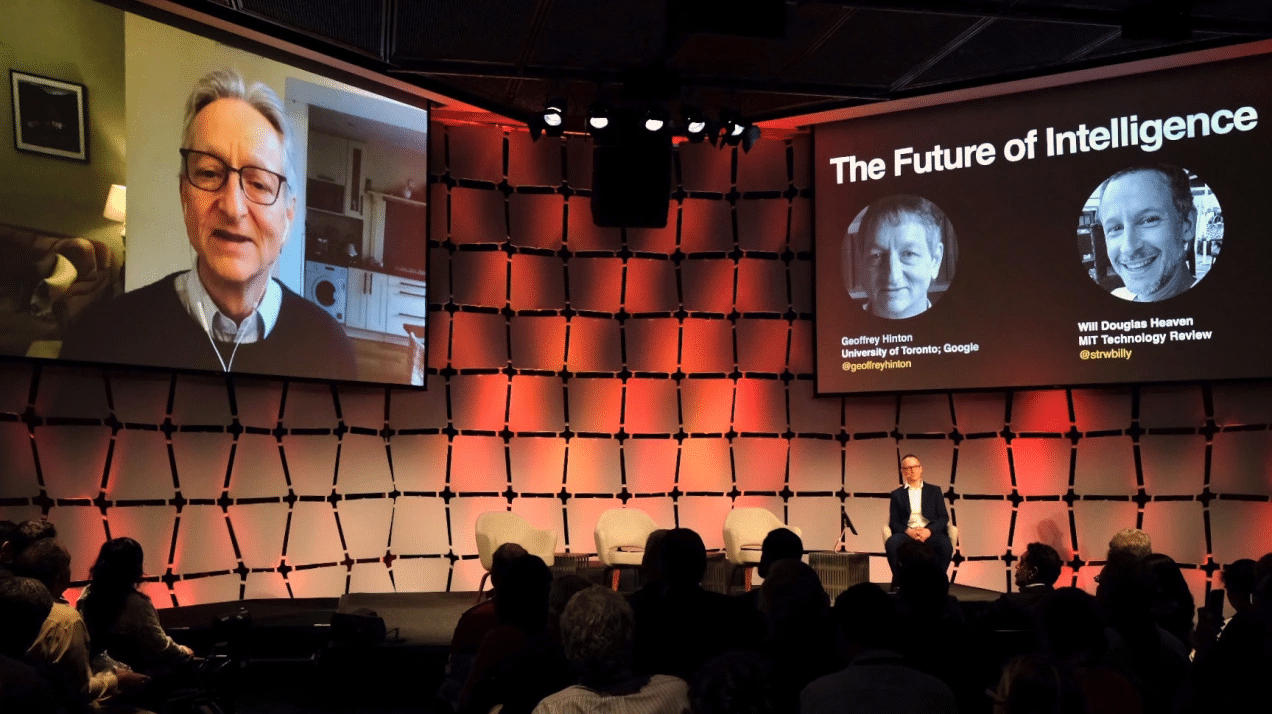

'딥러닝의 아버지' 제프리 힌턴이 지난 5월 2일 미국에서 진행된 MIT 테크놀로지 리뷰의 AI 콘퍼런스인 EmTech Digital에서 MIT 테크놀로지 리뷰 AI 담당 수석 에디터 윌 더글러스 헤븐(Will Douglas Heaven)과 대화를 나눴다.

제프린 힌턴(Geoffrey Hinton)은 캐나다 토론토 대학교의 명예교수이자, 구글의 엔지니어링 펠로로 일했다. 그리고 10년간의 근무 후 지난 5월 1일, 퇴임 소식을 알렸다.

제프리는 현대 AI에서 가장 중요한 인물 중 한 명이다. 딥러닝의 선구자인 그는 기계가 학습할 수 있는 기술인 역전파(back propagation)와 같이 AI의 근간이 된 기술을 개발했다. 그리고 2018년 얀 르쿤, 요슈아 벤지오와 함께 컴퓨터과학계의 노벨상이라 불리는 튜링상을 수상했다. 힌턴과 ‘지능’에 대한 이야기를 나누며 지능의 의미는 무엇인지, 기계가 지능을 구축하려는 시도가 우리를 어디로 이끌어 갈 것인지에 대해 논의했다.

*아래 내용은 독자의 이해를 돕기 위해 요약, 편집되었다.

금주 당신의 구글 퇴사 소식이 모든 뉴스에 등장했다. 퇴사를 결정하게 된 계기가 무엇인가?

여러 가지 이유가 있었다. 하나는 내가 75세이고 예전처럼 기술적인 일을 잘하지 못하고 있기 때문이었다. 프로그래밍을 하다 보면 할 일을 잊어버리는 경우도 많고, 한 마디로 은퇴할 때가 되었다.