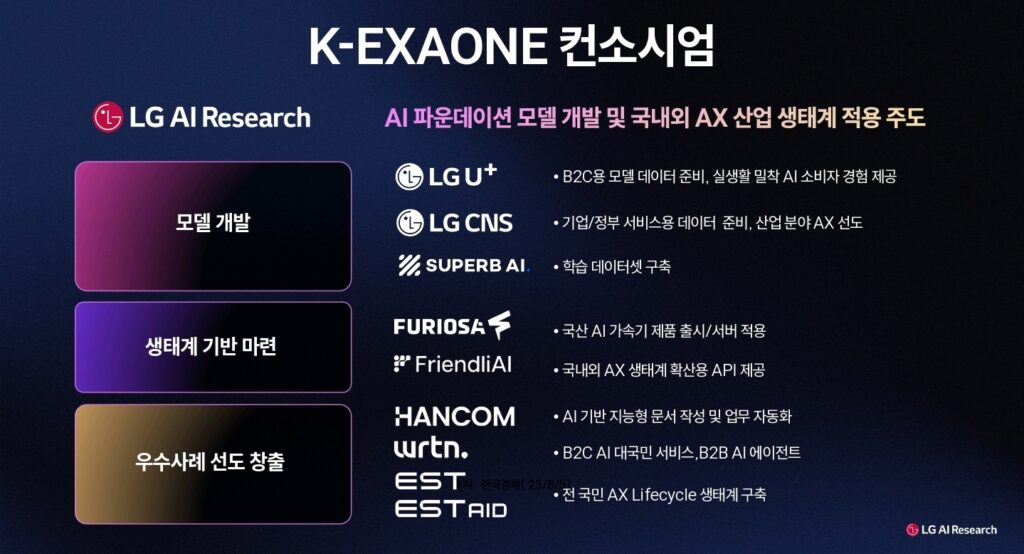

LG, 5개월 만에 미·중 AI 모델 추월한 ‘K-엑사원’ 공개

LG AI연구원은 지난 12월 30일 서울 코엑스에서 열린 과학기술정보통신부 주관 발표회에서 2,360억 개 매개변수(AI 모델의 크기를 나타내는 지표) 규모의 ‘K-엑사원(EXAONE)’이 미국과 중국의 대표 AI 모델을 추월했다고 밝혔다.

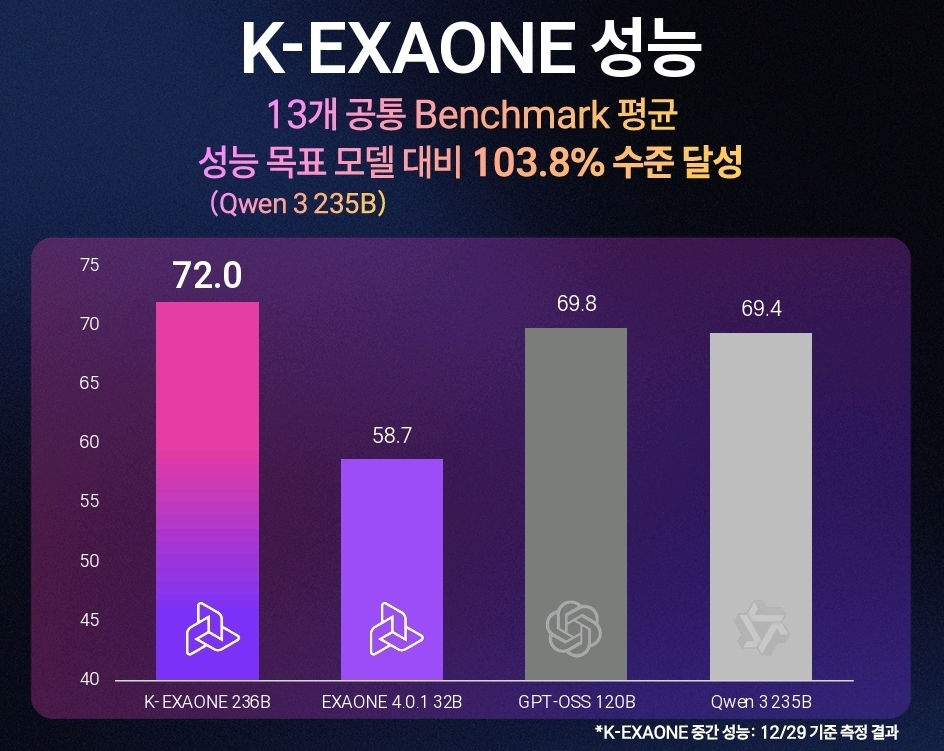

글로벌 AI 성능 평가 전문기관인 아티피셜 어낼리시스(Artificial Analysis)가 운영하는 순위에서 6~7위에 있는 챗GPT 개발사 오픈AI의 ‘GPT-OSS 120B’와 알리바바의 ‘큐웬3 235B’를 각각 103%, 104% 성능으로 앞선 것이다. 이들은 누구나 내부 구조를 들여다보고 수정할 수 있도록 설계도를 공개한 ‘오픈 웨이트(Open Weight)’ 모델 중 최상위권에 속한다.

K-엑사원은 AI 성능을 측정하는 13개 표준 테스트(벤치마크)에서 평균 72.03점을 기록하며 글로벌 톱 5 진입 가능성을 입증했다. 특히 지난 8월 개발에 착수한 지 불과 5개월 만에 이룬 성과라는 점에서 LG AI연구원의 기술 역량이 재조명받고 있다.

효율성으로 승부한 거대 AI

K-엑사원의 핵심은 단순한 규모 경쟁이 아닌 ‘효율’에 있다. LG AI연구원은 독자 개발한 전문가 혼합(MoE, Mixture of Experts) 구조를 통해 이 문제를 해결했다.

MoE는 하나의 거대한 AI 모델을 여러 개의 ‘전문가’ 네트워크로 나누는 기술이다. 마치 병원에 내과·외과·정형외과 등 전문의가 있듯이, AI 모델 내부에도 코딩에 특화된 전문가, 수학 문제 해결에 강한 전문가, 언어 번역을 잘하는 전문가 등이 각각 존재한다. 질문이 들어오면 ‘게이팅 네트워크’라는 일종의 교환원이 어떤 전문가가 이 문제를 가장 잘 풀 수 있는지 판단해 적절한 전문가만 선택적으로 활성화한다.

예를 들어 “파이썬으로 정렬 알고리즘을 작성해줘”라는 요청이 들어오면 전체 2,360억 개 매개변수 중 코딩 전문가에 해당하는 일부만 작동한다. 모든 전문가를 동시에 가동하지 않기 때문에 계산량이 획기적으로 줄어든다. 인간의 뇌가 모든 뉴런을 항상 사용하지 않고 필요한 부분만 활성화하는 것과 같은 원리다.

LG AI연구원은 여기에 하이브리드 어텐션(Hybrid Attention) 기술을 더했다. 어텐션은 AI가 문장을 이해할 때 어떤 단어에 집중할지 결정하는 메커니즘인데, 기존 방식은 모든 단어 쌍의 관계를 계산해 메모리를 많이 소모했다. 하이브리드 어텐션은 중요한 관계만 선택적으로 계산해 메모리 요구량과 연산량을 70% 줄였다.

이러한 최적화 덕분에 K-엑사원은 고가의 최신 GPU(그래픽처리장치, AI 연산에 필요한 핵심 부품)가 아닌 엔비디아(세계 최대 AI 칩 제조사)의 이전 세대인 A100 환경에서도 구동된다. 최상위 AI 모델을 돌리려면 보통 최신 H100이나 B200 같은 GPU 한 대당 수억 원이 필요한데, K-엑사원은 상대적으로 구형인 A100으로도 작동한다. 스타트업이나 중소기업도 최고 수준 AI를 도입할 수 있게 된 셈이다.

5년 축적의 결실, 5개월의 압축

LG AI연구원이 이처럼 빠르게 K-엑사원을 완성할 수 있었던 배경에는 2021년부터 쌓아온 엑사원 시리즈 개발 경험이 있다.

엑사원 1.0(2021년 12월) 발표 이후 2.0(2023년 7월), 3.0(2024년 8월), 3.5(2024년 12월), 4.0(2025년 3월)까지 지속적으로 모델을 진화시켜왔다. 특히 엑사원 3.0은 국내 최초로 누구나 무료로 사용하고 수정할 수 있는 ‘오픈소스(Open Source)’ AI 모델로 공개되며 전 세계 개발자 커뮤니티에서 주목받았다. AI 성능을 측정하는 13개 표준 테스트에서 1위를 기록하고, 이전 모델 대비 성능은 56% 향상되면서 비용은 72% 절감하는 성과를 거뒀다.

가장 최근에 공개된 엑사원 4.0(2025년 3월)은 추론 모델과 비추론 모델을 결합한 하이브리드 구조로, 320억 개 매개변수만으로도 중국 딥시크(DeepSeek)의 R1 모델(6,710억 개)이나 알리바바 큐웬3(2,350억 개)에 맞먹는 성능을 달성했다. 더 작은 크기로 비슷하거나 더 나은 성능을 내는 효율성 측면에서 세계 최고 수준이었다.

K-엑사원은 이러한 기술 축적 위에서 탄생했다. LG AI연구원은 기존 엑사원 4.0 대비 추론 효율성을 높이고 메모리 요구량을 줄이면서 모델 규모를 2,360억 개로 확대했다. 5년간의 노하우가 5개월이라는 짧은 개발 기간을 가능하게 한 것이다.

LG AI연구원 관계자는 “K-엑사원은 글로벌 최신 AI 모델 100% 이상 성능이라는 도전적인 목표를 달성했다”며 “향후 1조 개 단위 매개변수를 가진 글로벌 빅테크 최상위 모델들과 본격 경쟁할 수 있는 모델을 개발할 계획”이라고 밝혔다.

구광모 LG 대표는 2026년 신년사에서 “선택과 집중”을 강조하며 “타협할 수 없는 하나의 핵심 가치를 선택해야 하며, 남들이 불가능하다고 여기는 수준까지 파고들어야 한다”고 말했다. LG AI연구원이 선택한 핵심 가치는 명확하다. 미국과 중국이 주도하는 AI 경쟁 구도에서 한국을 ‘AI 3강 국가’로 만드는 것이다.

K-엑사원이 그 첫걸음이 될 수 있을지, 글로벌 AI 커뮤니티가 주목하고 있다.