구글이 흑인 여성 AI 윤리 연구자를 해고한 이유

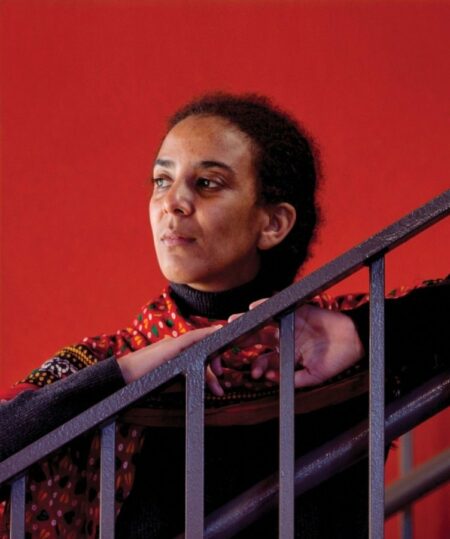

12월 2일 수요일 저녁 트위터를 통해, 구글 AI윤리팀 공동 책임자 팀니트 게브루는 구글에서 해고당했다고 밝혔다.

AI 윤리 연구 분야에서 명성이 높은 게브루는 획기적인 논문을 공동 집필했다. 이 논문에서 게브루는 인공지능이 여성과 유색인종에 대해서는 얼굴 인식 정확도가 떨어져, 이를 활용할 경우 차별로 이어질 수 있음을 밝혔다. 또한 ‘AI의 흑인들’ (Black in AI)을 공동 설립했고, 기술 산업의 다양성을 신장하는 활동을 했다. 구글에서 게브루가 관여한 팀은 AI 분야에서 가장 다양성을 띤 팀 중 하나이며, 손꼽히는 전문가들이 다수 포진하고 있다. 때때로 주류 AI 관행에 도전하는 괄목한 성과를 올려 업계 동료들의 부러움을 샀다.

일련의 트윗과 유출된 메일, 언론 기사들은 게브루가 공동 집필한 또 다른 논문을 둘러싼 회사와 게브루 간 갈등이 게브루의 사임으로 정점에 올랐음을 보여준다. 제프 딘(Jeff Dean) 구글 AI 책임자는 사내 메일(이후 온라인에 게재)을 통해 “논문은 출판 기준에 미달했다. 게브루는 조건이 맞지 않을 경우 사임하겠다고 했는데, 구글 입장에서는 게브루가 원하는 조건이 달갑지 않았다”고 밝혔다. 게브루는 휴가를 다녀오면 “마지막 일정”을 협상하기로 했다고 트윗했다. 하지만 휴가가 끝나기도 전에 게브루의 회사 이메일 계정이 차단되었다.

AI 윤리 분야의 여러 선구자들은 온라인상에서 게브루가 연구에서 드러난 불편한 진실을 밝혔기 때문에 쫓겨났다고 주장한다. 1,400명이 넘는 구글 직원과 1,900명의 지지자들이 항의 서한에 서명했다.