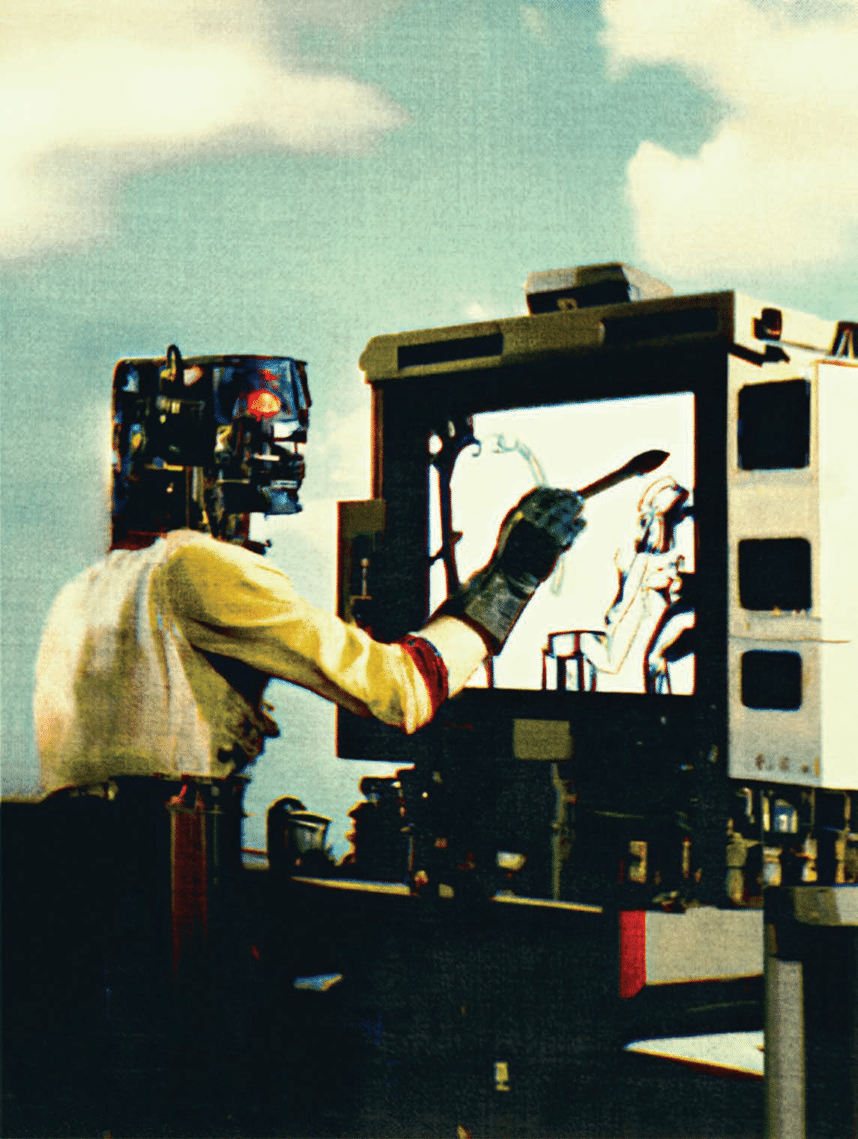

디지털 아티스트 에릭 카터(Erik Carter)가 이미지를 생성하는 AI 도구 DALL-E 2를 이용하여 불안해 보이는 이미지들을 만들고 있다. Eric Carter

2023년 10대 미래 기술

본 기사는 MIT 테크놀로지 리뷰의 2023년 10대 미래 기술로 선정된 ‘이미지 생성 AI’의 시리즈 기사입니다.

오픈AI(OpenAI)가 무언가 대단한 일을 해낸 것이 분명했다. 2021년 말 오픈AI의 소규모 연구팀은 회사의 샌프란시스코 본사 사무실에서 어떤 아이디어를 실험해 보고 있었다. 이들은 자사의 ‘텍스트-이미지(text-to-image)’ 모델 ‘DALL-E’의 새로운 버전을 제작한 상황이었다. DALL-E는 이를테면 ‘반 고흐(Van Gogh)가 그린 여우 한 마리’, ‘피자로 만든 강아지’ 같은 짧은 텍스트를 입력하면 이를 이미지로 변환하여 생성하는 AI 모델이다. 이제 연구팀은 DALL-E의 새 버전으로 무엇을 할 수 있을지 알아내야 했다.

오픈AI의 공동 설립자이자 CEO 샘 올트먼(Sam Altman)은 MIT 테크놀로지 리뷰에 “거의 항상 우리는 무언가를 새로 제작하면 한동안 직원 모두가 그 제품을 사용해야 한다”며 “그 과정에서 해당 제품이 어떤 제품이 될지, 어떤 용도로 사용될지 파악하려고 한다”라고 설명했다.

이번에는 다른 때와 달랐다. DALL-E의 새 버전을 조작해 보던 연구원들은 이번 모델이 무언가 특별하다는 사실을 깨달았다. 올트먼은 “우리가 대단한 무엇을 만들어낸 것이 분명했다. DALL-E 2는 우리가 바라던 바로 그 제품이었다. 논쟁이 필요 없었고 회의조차 연 적이 없다”라고 밝혔다.