DALL-E

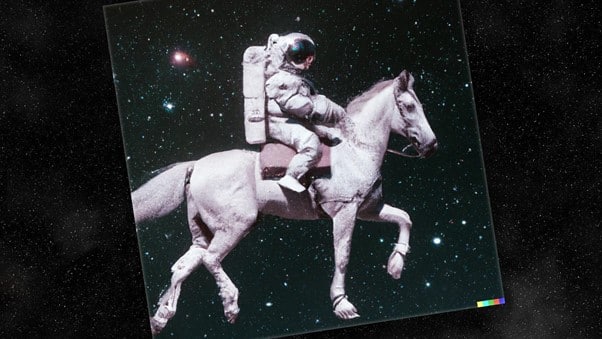

This horse-riding astronaut is a milestone in AI’s journey to make sense of the world

이 말 타는 우주비행사 이미지는 AI가 세상을 이해하는 과정에서 중요한 단계를 보여준다

오픈AI가 새로 발표한 이미지생성 AI ‘DALL-E 2’가 만들어내는 이미지들은 놀라울 정도로 훌륭하다. 이 AI는 우리가 AI의 지능을 어떻게 정의해야 할지 의문을 던진다.

미국의 인공지능 연구소 오픈AI(OpenAI)가 2021년 초에 그림을 생성하는 신경망(neural network) DALL-E를 발표했을 때 DALL-E는 다양한 개념을 새로운 방식으로 조합하는 사람 같은 능력을 보여주며 사람들을 놀라게 했다. 요청에 따라 DALL-E가 생성한 일련의 이미지들은 초현실적이고 만화 같기도 했지만 한편으로는 DALL-E라는 AI가 세상에 적응하는 중요한 방법들을 배웠음을 드러내기도 했다. 당시 DALL-E가 만든 아보카도 안락의자 이미지에는 아보카도와 의자의 기본적인 특징들이 모두 포함돼 있었다. 또한 DALL-E가 만든 ‘발레리나 치마를 입고 개를 산책시키는 무’는 허리에 발레리나 치마를 입고 손에 개 목줄을 잡고 있는 무의 모습을 보여줬다.

6일 오픈AI는 DALL-E의 후속작 ‘DALL-E 2’를 발표했다. DALL-E 2는 기존 버전보다 훨씬 품질이 뛰어난 이미지를 생성하며, 사용법도 더 간단하고, 오리지널 버전과는 달리 나중에 문제점 개선 작업을 거친 후에 일반 대중에게도 공개될 예정이다. 놀라운 성능을 보이는 DALL-E 2는 우리가 AI라는 개념을 검토하고 AI에 대해 다시 새로운 정의를 내리게 만들지도 모른다.