자료. 오픈AI

This avocado armchair could be the future of AI

인공지능의 미래를 보여주는 아보카도 안락의자

오픈AI는 자연스러운 문장을 만들어내는 인공지능 모델 GPT-3로 세상을 놀라게 했다. 이제 자연어처리와 이미지 인식을 결합한 새로운 AI 모델 2가지를 새롭게 개발, GPT-3의 기능을 확장했다. 인공지능이 일상의 개념들을 보다 잘 이해하게 된다.

오픈AI는 엄청나게 많은 텍스트를 던져주는 것만으로 인공지능(AI)이 언어를 다양한 방식으로 사용하도록 훈련시킬 수 있음을 보여주었다. 이어 학습 대상만 텍스트에서 픽셀로 바꾸어, 같은 방식으로 AI를 훈련시켜 반쯤 그려진 이미지를 완성시키게끔 하는 ‘이미지 GPT’ 프로젝트도 성공했다. GPT-3는 사람이 단어를 사용하는 법을 모방한다. 이미지 GPT-3는 사람이 보는 것을 예측한다.

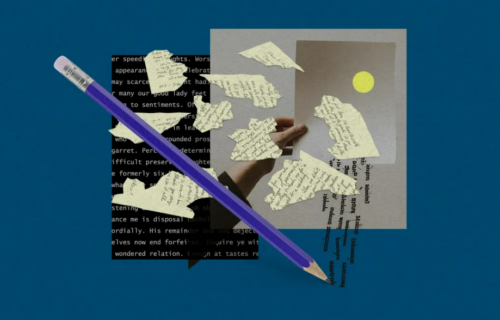

이제 오픈AI는 이러한 아이디어들을 결합해 DALL-E와 CLIP이라는 두 가지 새로운 인공지능 훈련 모델을 새로 개발했다. 이 모델들은 언어와 이미지를 결합해 인공지능이 단어와 그 단어가 무엇을 가리키는 지를 더 잘 이해하도록 한다.

오픈AI 수석 과학자 일리아 수츠케버(Ilia Sutskever)는 “우리는 시각적 세계에 산다”며 “장기적으로, 텍스트와 이미지를 모두 이해하는 AI 모델이 나올 것이다. AI는 단어와 문장이 무엇을 의미하는지 볼 수 있기 때문에 언어를 더 잘 이해하게 될 것”이라고 말했다.

GPT-3는 놀라운 성능에도 불구하고, 현실과 동떨어진 것처럼 느껴지는 결과물을 내놓는 경우가 종종 있다. 마치 자기가 무슨 말을 하는지 모르는 채 말을 하는 듯하다. 그건 GPT-3가 실제로 자기가 무슨 말을 하는지 모르기 때문이다. 이미지에 기반을 두고 텍스트를 이해하게 함으로써 AI 언어 모델이 사람들이 사물을 이해하기 위해 사용하는 일상의 개념들을 더 잘 이해하게 할 수 있으리라고 학계에선 보고 있다.