Evolving to a more equitable AI

편향성 없는 AI 만들기 위한 숙제

AI는 팬데믹 이후 정상을 회복하기 위한 강력한 도구가 될 수 있다. 단, AI 도입과 사용이 모든 이에게 공정하게 이루어져야 할 것이다.

이 기사는 세일즈포스(Salesforce)와 제휴해 작성되었습니다.

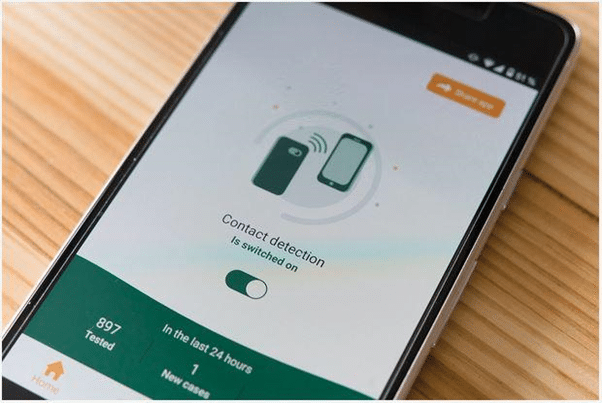

지난 한 해 동안 전 세계를 휩쓴 코로나19는 엄혹한 현실의 여러 단면을 있는 그대로 보여주었다. 팬데믹 대응 역량의 차이, 보건과 기술, 과학에 대해 개별 집단이 보여준 태도, 심각한 경제적, 사회적 불평등이 그것이다. 세계가 여전히 코로나19 위기에서 벗어나기 위해 노력하는 가운데, 또 일부 지역은 회사와 학교의 문을 열고 여행과 여가 활동을 점진적으로 재개하는 가운데, 공중보건의 공정성 확립과 프라이버시 보장이라는 서로 대립하는 과제를 해결하는 것이 중요한 일이 되었다.

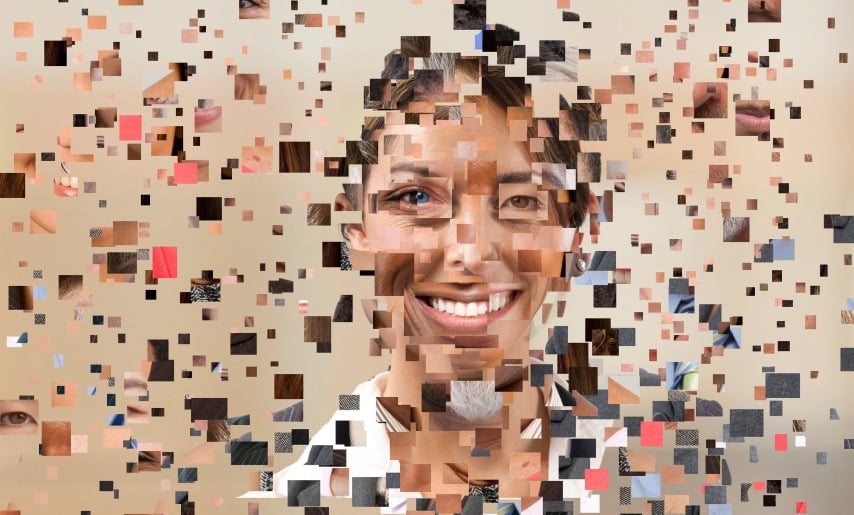

위기의 장기화로 직장과 사회에서의 행동이 빠른 속도로 변화하고 기술에 대한 의존도도 높아졌다. 이제 기업과 정부, 사회가 기술을 적용하고 개인정보를 취급할 때 주의를 기울이는 것이 그 어느 때보다 중요한 시대가 되었다. 적응형 기술(Adaptive technologies)이 잠재적으로 위험하거나 불공정한 방식으로 우리 생활과 사회제도에 스며드는 경향이 크다는 것이 인공지능의 급속한 도입과 확산 과정에서 입증되었기 때문이다.

“팬데믹이 종료되면 우리와 기술의 관계가 총체적으로 달라져 있을 것”이라고 세일즈포스의 윤리적 AI 책임자 요아브 쉴레진저(Yoav Schlesinger)는 말한다. “사람과 기업, 정부, 기술이 협상을 하게 될 것이다. 데이터에 관한 새로운 사회계약의 틀에서 이들 당사자 간 데이터 이동 방식을 둘러싼 협상이 다시 전개될 것이다.”