[인터뷰] 김종원 GIST 슈퍼컴퓨터센터장, “AI 연구에 삽 대신 포크레인이 필요하다”

최근 AI 기업들의 당면한 문제 중 하나는 날이 갈수록 증가하고 있는 데이터와 컴퓨팅 자원이다. 다시 말해 AI 관련 기업들은 AI 연구와 개발에 필요한 컴퓨팅 용량과 성능이 한계치에 달하면서 더 나은 방법을 찾아 나서고 있다. 최근 많은 기업이 AI를 위한 인프라로 HPC(High-Performance Computing)를 선택하고 있는 것 또한 이런 노력의 일환이다.

예를 들면 130조 원을 투자해 AI를 위한 슈퍼컴퓨터를 구축하겠다고 발표한 마이크로소프트와 오픈AI를 비롯해, 메타의 AI RSC(Research Super Cluster), 구글의 A3 등 주요 기업들은 저마다 AI용 슈퍼컴퓨터를 앞다퉈 공개하고 있다. 국내에서도 네이버가 국내에서 제일 빠른 슈퍼컴퓨터로 알려진 ‘세종’을 공개하는 등 HPC를 중심으로 AI 주도권 확보에 나서고 있다.

기업뿐 아니라 정부 차원의 투자도 이어지고 있다. 영국의 ‘이점바드-AI(Isambard-AI)’나 우리나라의 슈퍼컴퓨터 6호기가 바로 AI에 특화된 슈퍼컴퓨터로 설계와 구축이 진행되고 있다.

이처럼 기업과 정부가 나서서 AI를 위한 HPC 인프라 구축에 서두르고 있는 이유는, HPC가 AI 경쟁력 확보를 위한 필수 요소라는 인식 때문이다. 특히 LLM(Large Language Model)을 비롯한 생성 AI 기술은 기존의 워크스테이션이나 단일 서버 수준에서 이뤄지던 AI 연구나 개발과 달리 강력한 컴퓨팅 성능을 제공하는 HPC(High Performance Computing)로 이동할 수밖에 없기 때문이다.

하지만 국내 AI 연구개발과 서비스 환경은 대부분 소규모의 컴퓨팅 인프라 중심으로 이뤄지고 있어, 세계적인 AI 연구의 흐름에서 점점 뒤처지고 있다는 지적도 있다.

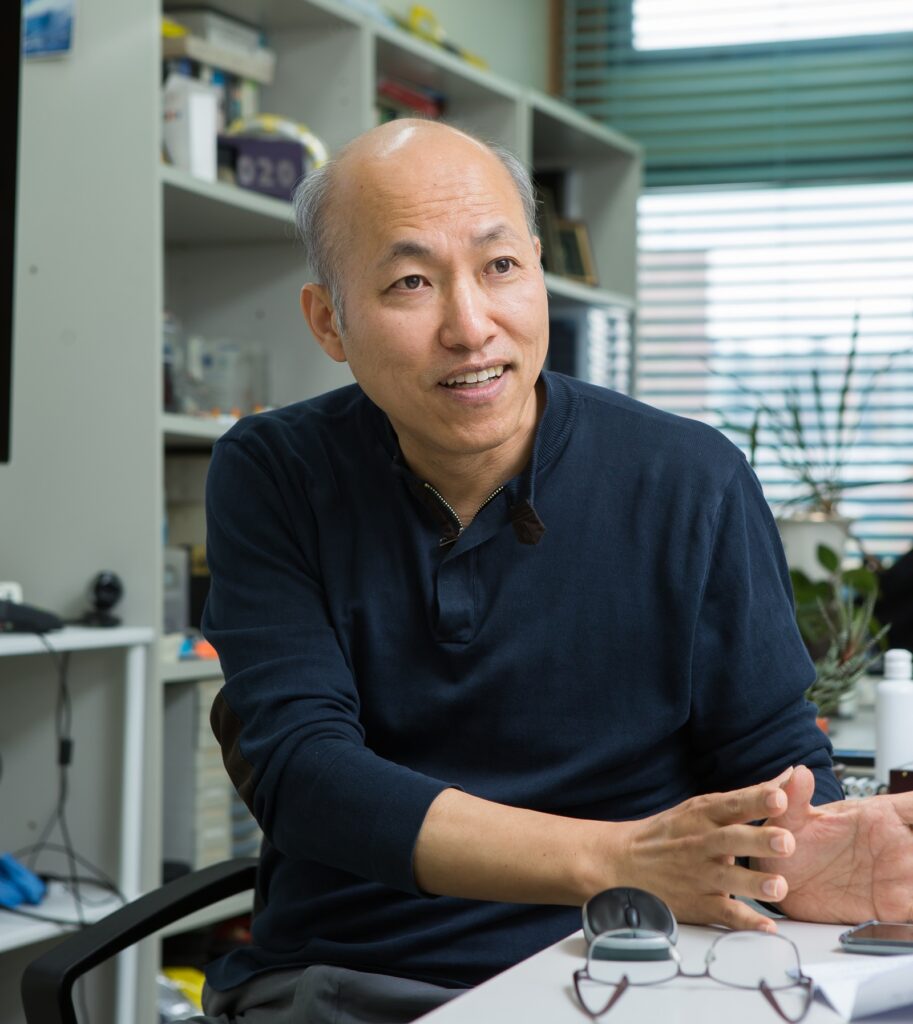

“미국, 중국, 유럽 등에서는 AI라는 건물을 세우기 위해 포크레인으로 작업하고 있는 가운데, 우리나라는 아직도 각각의 연구자들에게 삽을 쥐여주고 있다”며, 슈퍼컴퓨터의 필요성을 역설하고 있는 광주과학기술원(이하 GIST) 슈퍼컴퓨팅센터 김종원 센터장을 만나, AI 개발과 운영에서 HPC의 역할과 중요성에 대해 들어봤다.

GIST의 슈퍼컴퓨팅센터는 AI에 특화된 HPC 인프라로 ‘HPC-AI 공용인프라 데이터센터’를 표방하고 있다. 이 슈퍼컴퓨팅센터는 지난 2022년 SC(Supercomputing Conference)에서 발표한 전 세계 상위 500개 슈퍼컴퓨터 중 178위, 그리고 국내 슈퍼컴퓨터 중에서는 6위를 차지했었다.

GIST의 슈퍼컴퓨팅센터의 역할에 대한 설명을 부탁드립니다.

슈퍼컴퓨팅 센터는 연구자들과 학생들이 AI 개발과 실험을 원활하게 할 수 있도록 환경을 조성하고 지원하기 위한 것입니다.

AI 시스템은 컴퓨터와 네트워킹이 연결된 환경에서 운용돼야 합니다. 그리고 이런 컴퓨팅과 네트워킹이 원활하게 동작해 AI를 개발하고 운영하는 것을 돕는 것이 바로 슈퍼컴퓨팅센터의 역할입니다.

이제는 AI와 HPC는 결코 분리해서 생각할 수 없는 존재가 되고 있습니다. 그리고 AI를 개발, 운영하는 경쟁력은 HPC와 같은 대규모 컴퓨팅 환경이 없으면 결코 확보할 수 없는 상황이 되고 있습니다. 이런 HPC가 바로 한국의 기술 발전을 위해 필요한 핵심역량이라고 생각했기에 AI를 위한 HPC 인프라인 ‘드림-AI(Dream-AI)’를 구축하게 된 것입니다.

AI를 위한 HPC라는 개념을 다른 곳보다 상당히 빨리 적용한 것으로 알고 있습니다.

지난 2021년부터 AI 연구에 HPC가 필수 요소라고 역설해 왔으나, 효용성에 의문을 품는 사람들이 많았습니다. AI 연구에 있어서 HPC의 필요성에 대한 의문을 던진 것입니다. 하지만 오픈AI에 의해 챗GPT가 발표되고 LLM과 같은 거대한 HPC 인프라를 요구하는 AI 기술이 등장하면서 상황이 크게 역전됐습니다.

개인적으로는 슈퍼컴퓨팅 컨퍼런스에 20번 가까이 참석하면서 장기적으로 AI 분야에서 HPC에 대한 필요성을 피부로 느끼고 있었으나 이를 설득하기 쉽지 않았는데, 챗GPT가 기존의 고정관념을 부숴버린 것입니다.

현재는 많은 슈퍼컴퓨터들이 AI를 지원하는 형태로 등장하고 있습니다. 특히 최근에는 GPU 기반의 슈퍼컴퓨터들이 속속 등장하고 있습니다.

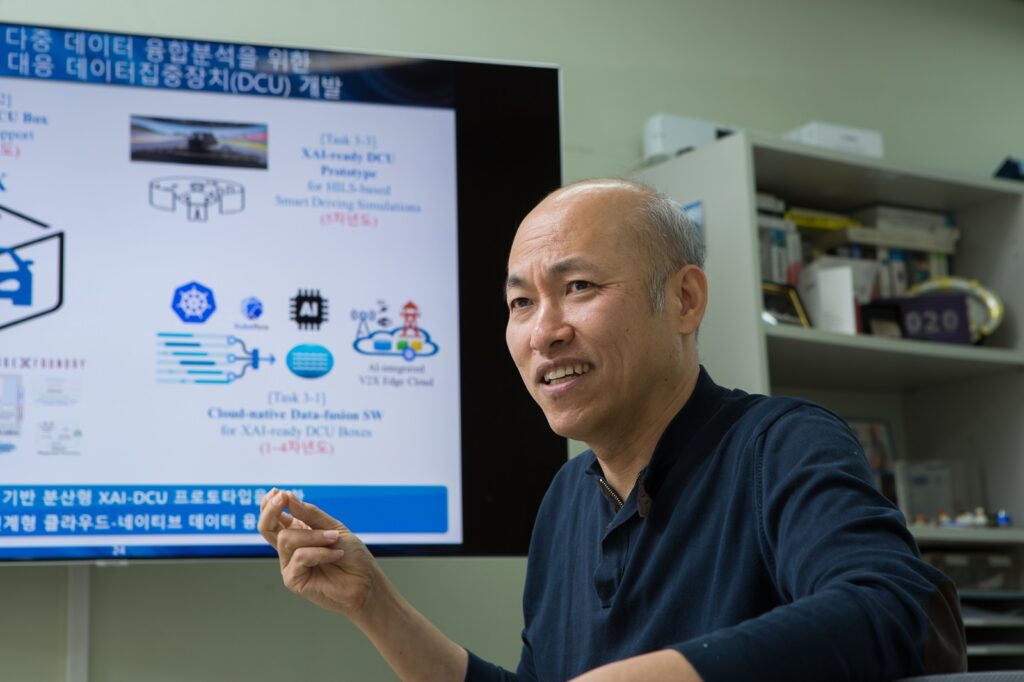

클라우드 네이티브 기반의 AI 인프라 구축과 관리 측면에 많은 관심을 갖고 계신 것으로 보입니다.

드림-AI의 기본적인 디자인은 클라우드 네이티브 방식으로 구성돼 있습니다. 클라우드 네이티브 방식은 컨테이너 기반의 마이크로 서비스 아키텍처로 구성돼 있기 때문에, 호환성과 이식성 측면에서 강점을 발휘합니다.

일반적으로 슈퍼컴퓨터를 사용할 때, 애플리케이션을 처음 개발 과정부터 슈퍼컴퓨터에서 하는 경우는 거의 없습니다. 대부분 다른 곳에서 제작한 애플리케이션을 고도의 연산 작업이 필요할 경우 슈퍼컴퓨터의 자원을 빌려서 사용해야 하는데, 이 과정에서 호환성 혹은 이식성 문제가 발생하는 경우가 많습니다. 그러나 클라우드 네이티브 방식의 슈퍼컴퓨팅 환경에서는 이런 문제가 발생할 여지를 크게 줄일 수 있습니다. 이제는 기업들도 클라우드 네이티브 기반의 AI 서비스를 강조하고 있습니다. AWS와 같은 클라우드 서비스 업체는 물론이고 엔비디아 또한 클라우드 네이티브 슈퍼컴퓨팅이라는 부분을 강조하고 있습니다. 그리고 이런 흐름은 자연스럽게 클라우드 네이티브 방식의 AI 개발과 운영이 연구 분야에서부터 실제 상용화 서비스에 이르기까지 폭넓게 적용될 것입니다.

GIST에서 슈퍼컴퓨팅센터를 운영하는 이유는 무엇이며, 어떤 용도로 활용하고 있는지 설명 부탁드립니다.

한 국가의 과학 기술 경쟁력 측면에서 가장 중요한 것은 인프라입니다.

많은 연구가 실험적인 방법과 이론적인 방법으로 이뤄지고 있는데, 이 중 실험적인 방법을 시뮬레이션으로 수행하는 경우가 점점 늘고 있습니다. 시뮬레이션으로 실제 실험에 드는 시간과 노력을 크게 줄일 수 있기 때문입니다. 그리고 이런 시뮬레이션 실험을 위한 기반이 되는 것이 바로 HPC 인프라입니다.

현재의 슈퍼컴퓨팅센터를 본격적으로 시작한 것은 2021년이었습니다. 초기부터 AI를 위한 HPC 인프라를 구성한다는 컨셉으로 시작해, 과기정통부에서 지정한 10대 전문센터 중 하나로 ‘자율주행 초고성능컴퓨팅 전문센터’ 역할을 맡고 있습니다.

AI 개발과 운영에서 HPC는 굉장히 큰 부분을 차지하고 AI 비용의 대부분이 컴퓨팅 인프라 도입과 운영 비용이라고 알고 있습니다.

LLM의 등장은 AI를 위한 HPC의 필요성을 강조하고 있습니다. 그리고 그 규모 또한 점점 커지고 있습니다.

이미 많은 클라우드 서비스 업체들이 AI 전용 서비스를 제공하고 있습니다. 물론 클라우드 서비스 업체의 상품이 더 많은 CPU나 GPU를 제공할 수 있을지는 모르겠지만, 그렇다고 하더라도 AI 구동을 위한 실제 성능에서는 HPC와 현격한 차이가 납니다. 바로 고속의 인터페이스 때문입니다. 다시 말해 클라우드 서비스는 스케일링에 한계가 있기 때문에 결국은 HPC가 필요할 수밖에 없습니다.

물론 HPC 인프라의 도입과 운영에는 엄청난 비용이 들어갑니다. 하지만 HPC는 HPC만이 할 수 있는 일과 영역이 있습니다. AI를 위한 HPC 또한 마찬가지입니다. 우리나라의 AI 관련 투자는 결코 적은 수준이 아닙니다. 문제는 초기 연구나 단순 연구에나 사용할 수 있는 소규모 인프라 구축이 주로 이뤄지고, 대규모의 작업에 필요한 HPC 인프라의 구축은 거의 이뤄지지 않고 있습니다. 다시 말해 연구자 개개인에게 삽을 쥐여주는 대신 모두가 함께 사용할 수 있는 포크레인을 도입하는 방식으로의 전환이 필요합니다.

물론 삽과 같은 소규모 인프라 또한 분명한 역할이 있지만, 소규모 인프라가 모인다고 해도 결코 대규모 HPC의 역할을 대신할 수는 없기 때문입니다.