Auditors are testing hiring algorithms for bias, but there’s no easy fix

AI 알고리즘 분석해 편향 극복할 수 있나?

AI 채용 알고리즘에 대한 감사(audit)를 실시해도 편향을 발견하지 못할 수 있다. 또 가장 우수한 인재를 가려 주는 것도 아니다.

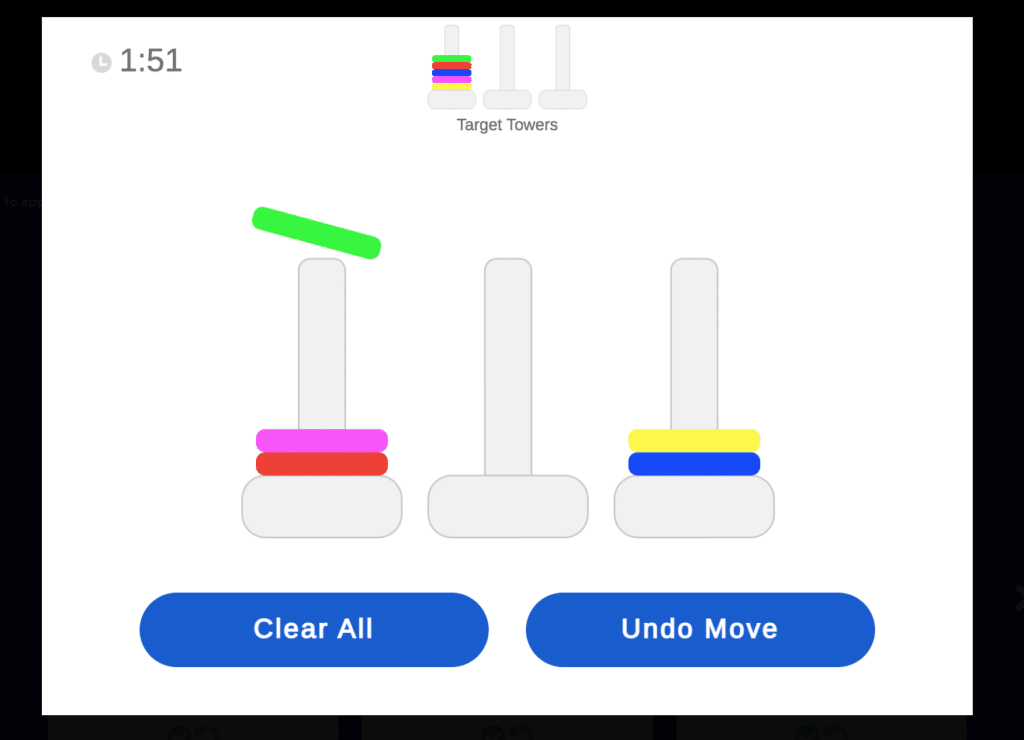

나는 지금 집에서 컴퓨터로 비디오 게임을 하는 중이다. 풍선을 하나씩 불 때 마다 5센트가 적립된다. ‘불기’ 버튼을 눌러 풍선을 불고, 풍선이 터지기 전에 ‘모으기’ 버튼을 눌러야 한다. 어쩌다 ‘모으기’ 버튼을 늦게 누르면 그동안 모은 돈을 모두 잃을 수도 있다.

지금까지 풍선 39개를 불고 14.40달러를 모았다. 그런데 갑자기 화면에 메시지가 나타난다. “당신은 고위험 상황에서도 같은 접근법을 고집합니다. 당신은 ‘위험감수형’입니다”.

이 게임은 파이매트릭스(Pymetrics)가 개발한 채용 도구 중 하나이다. 현재 미국의 많은 기업이 이 도구를 채용 절차에 도입했다. 맥도날드, 보스턴컨설팅그룹, 크래프트하인즈, 콜게이트-팜올리브 등이 대표적이다.

당신이 게임을 하는 동안 AI는 관대함, 공정함, 주의력 등 성격 유형을 측정한다. 이 게임을 도입한 기업에 지원한다면, AI는 나의 결과를 내가 지원한 직군에서 일하는 직원들이 얻은 결과와 비교한다. 나의 성격 특성이 고성과자와 비슷하다고 판명되면 다음 단계로 넘어갈 수 있다.

코로나19 사태 이후 미국에서 실직자가 거의 두 배로 증가하면서 물밀듯 밀려드는 지원서를 처리하기 위해 이 같은 AI 기반 채용 도구를 도입하는 기업이 점점 늘고 있다. 자산운용사 머서가 세계 각국 인사관리자 7,300명을 대상으로 실시한 조사에 따르면 예측적 분석 도구 활용 비율이 2016년 10%에서 2020년 39%로 급증했다.

지원자의 사회적, 인지적, 정서적 특성을 판별할 수 있다고 주장하는 파이매트릭스 AI 게임 화면

파이 매트릭스 제공