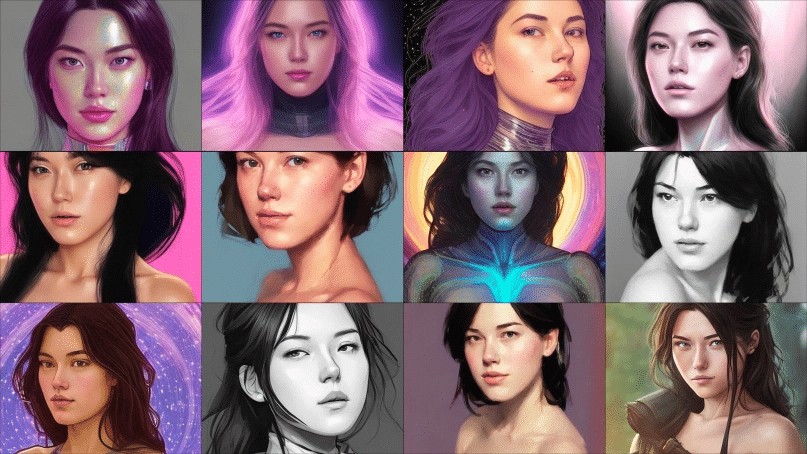

MELISSA HEIKKILÄ VIA LENSA

The viral AI avatar app Lensa undressed me—without my consent

내 셀카를 성적인 아바타로 만든 AI 아바타 앱

유명한 AI 아바타 앱 렌사(Lensa)가 여성 이용자의 셀카를 성적 이미지를 연상시키는 아바타로 바꾸어 버리는 문제가 발견되었다. 남자 이용자들의 아바타는 우주 비행사, 탐험가, 발명가였지만 여성 이용자의 아바타는 만화 캐릭터 같은 선정적인 모습을 하고 있었다.

이용자들 사이에서 인기를 끌며 입소문을 타고 있는 아바타 앱 렌사(Lensa)를 처음 사용하면서 나는 MIT 테크놀로지 리뷰의 남자 직원들과 비슷한 결과를 기대했다. 렌사는 디지털 이미지를 수정하는 앱으로 2018년 첫 선을 보였다. 최근 렌사는 셀카를 기반으로 디지털 초상화를 생성해 주는 AI 기반의 매직 아바타(Magic Avatars) 기능을 추가하면서 큰 인기를 끌고 있다.

렌사는 내 남자 동료들에게 현실적이면서도 꽤 과장된 아바타를 생성했다. 멋진 전자음악 앨범의 커버 사진과 함께 우주 비행사, 용맹한 전사 모습을 한 아바타들이 나타났다. 그러나 내가 앱을 실행한 결과는 달랐고 수많은 알몸의 아바타가 나타났다. 내가 생성한 100개의 아바타 중 16명은 상의를 노출했고 다른 14명은 극도로 노출이 심한 옷을 입고 선정적인 포즈를 취하고 있었다.

아시아 인종으로서의 나의 특징이 렌사의 AI 모델이 내 셀카에서 찾아낸 전부인 듯했다. 분명히 만화나 게임 캐릭터에서 가져온 아시아 여성들의 이미지였기 때문이었다. 대다수가 알몸이거나 노출이 심하다는 점을 고려하면 포르노에서 온 것일 가능성도 다분했다. 몇 개의 이미지들에서 나의 아바타는 마치 울고 있는 표정처럼 보였다. 그렇지만 한 백인 여성 동료의 경우는 선정적인 이미지가 훨씬 적었고 일부에서만 알몸이거나 가슴골이 살짝 보이는 정도였다. 다른 중국계 여성 동료는 숱하게 많은 양의 선정적인 아바타들로 도배되며 나와 비슷한 결과를 보였다.