AI 언어 프로그램을 학습시킬 데이터가 부족할 수 있다

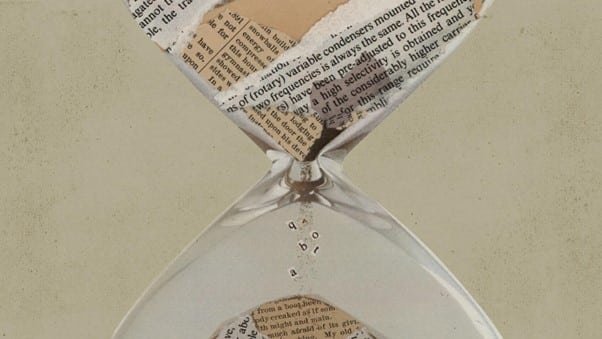

대규모 언어모델(large language model)은 현재 AI 연구에서 가장 인기 있는 분야 중 하나이며 기업들은 매우 논리 정연한 기사나 심지어 컴퓨터 코드까지 작성할 수 있는 GPT-3 같은 프로그램을 출시하기 위해 경쟁하고 있다. 그러나 AI 분야의 어떤 연구팀이 발표한 논문에 따르면 언어모델을 둘러싼 이러한 흐름에 곧 문제가 생길 것으로 보인다. 대규모 언어모델을 학습시킬 데이터가 부족해질 수도 있기 때문이다.

언어모델은 위키피디아, 뉴스 기사, 과학 논문, 책 같은 출처에서 가져온 다양한 텍스트를 사용하여 학습한다. 최근 몇 년 동안은 이러한 모델을 더 정확하고 다재다능하게 만들고자 하는 바람으로 점점 더 많은 데이터를 사용해서 교육하는 추세였다.

문제는 언어모델을 학습시키는 데 일반적으로 사용하는 유형의 데이터가 가까운 미래에 고갈될지도 모른다는 점이다. AI 연구 및 예측 기관 에포크(Epoch)의 연구팀이 발표한 논문에 따르면 이르면 2026년에 데이터가 고갈될 것으로 보인다(이 논문은 아직 동료평가를 거치지 않았다). 이러한 문제가 발생하는 이유는 연구원들이 더 뛰어난 능력을 가진 더 강력한 모델을 만들려면 언어모델 학습에 사용할 더 많은 텍스트를 찾아야 하기 때문이다. 이번 에포크의 연구에는 참여하지 않은 AI 기업 허깅페이스(Hugging Face)의 연구원 테븐 르 스카오(Teven Le Scao)는 대규모 언어모델 연구자들 사이에서 언어모델 학습에 사용할 데이터가 고갈될 것이라는 우려가 점점 더 커지고 있다고 말했다.