AI 비즈니스에서 데이터 윤리는 왜 중요한가?

이제 정확한 데이터 라벨링, 데이터의 윤리적 사용, 프라이버시의 적절한 보호, 알고리즘 편향을 제거하기 위한 노력은 AI 비즈니스의 성패를 좌우하는 요소가 되었다.

많은 기업들은 AI로의 전환을 시도하고 새로운 비즈니스 모델을 찾고 있다. AI는 비즈니스에 새로운 가능성을 열어주지만 한편으로는 데이터 윤리의 리스크도 확장시킨다.

AI 시스템을 구축하려면 무엇보다 데이터가 필요하다. AI가 학습하는 데이터는 먼저 사람이 분류하고 라벨링하는 단계를 거치는데 그 과정에 소요되는 시간은 R&D의 80퍼센트를 차지한다.

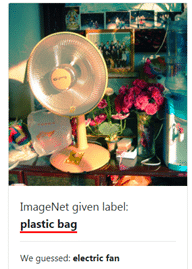

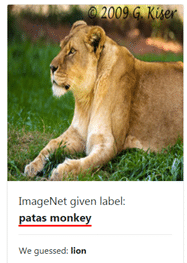

인간에 의한 라벨링 오류도 나타나게 된다. 머신 비전에 사용되는 대표적 시각적 데이터세트는 이미지넷(ImageNet)인데 1,400만 건을 보유하고 있다. 스탠포드대의 페이페이 리(Fei-Fei Li)가 유명해진 이유는 이미지 인식 경진대회 때문이었다. 그런데 이미지넷에 라벨링(labeling) 오류가 상당하다는 점이 드러났다.

MIT CASIL 대학원생들이 찾아낸 이미지넷 데이터 라벨링 오류들(https://labelerrors.com)은 다양했는데 꿀벌을 개미로, 개구리를 고양이로 인식하는 오류, 아기 입에 물려진 공갈 젖꼭지를 여성의 유두로 인식하는 오류 뿐만 아니라 인종차별적, 성차별적 라벨링, 동의를 받지 않은 개인 사진까지 발견되었다. 손글씨 숫자 이미지 7만 건으로 이루어진 MNIST 데이터세트에서도 잘못된 라벨링이 발견되었다.