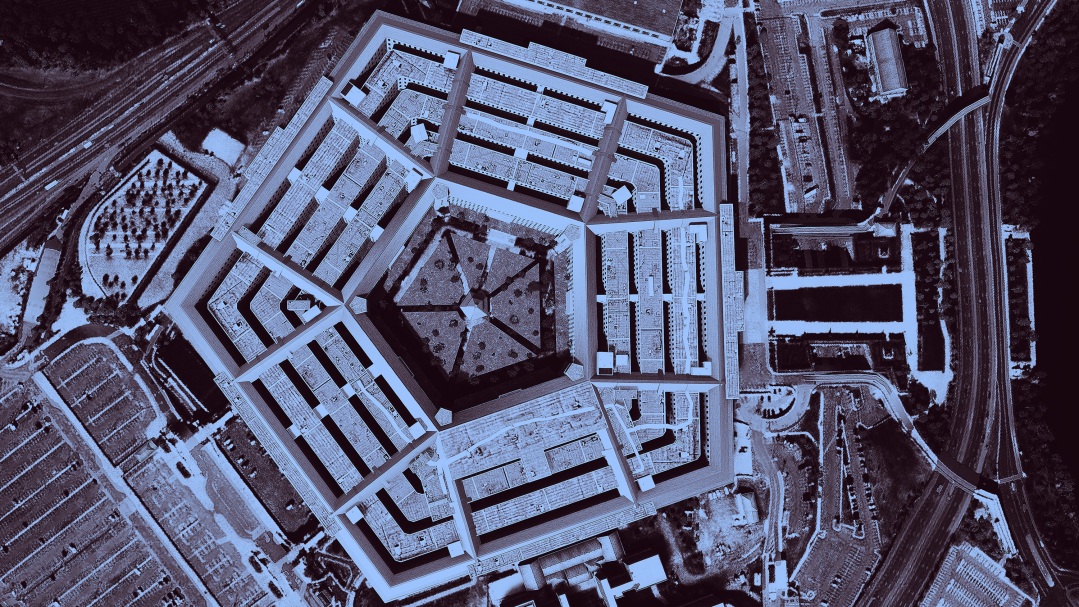

MS TECH | GETTY

The Department of Defense is issuing AI ethics guidelines for tech contractors

美 국방부가 기술기업을 위해 AI 윤리 가이드라인을 마련한 이유

과거 전력 강화책인 ‘프로젝트 메이븐(Project Maven)’을 둘러싼 논란으로 신뢰에 심각한 타격을 입은 미국 국방부가 신뢰 회복을 위해 인공지능(AI) 윤리 가이드라인을 마련했다.

2018년 구글 직원들이 구글이 논란이 많았던 ‘프로젝트 메이븐’에 관여했다는 사실을 알고 행복하지 않았다. 메이븐 프로젝트는 AI 기술을 기반으로 국방부가 수집한 영상 정보를 해석해 드론의 타격 정확도를 향상시키기 위해 추진됐던 프로젝트다.

구글의 관여 사실을 안 구글 직원 수천 명이 항의에 나섰다. 직원들은 회사 경영진에 보낸 서한에서 “우리는 구글이 전쟁 사업에 관여해서는 안 된다고 믿는다”라고 적었다. 약 12명의 직원이 회사를 떠났고, 결국 구글은 2019년 국방부와 맺었던 계약을 갱신하지 않았다.

프로젝트 메이븐은 여전히 존재한다. 아마존과 마이크로소프트를 포함한 다른 기술 기업들이 구글이 떠난 자리를 채웠다. 그러나 미 국방부는 이로 인해 신뢰에 타격을 입었다는 사실을 인지하고 있다. 최신 기술, 특히 AI를 계속 이용하기 위해서는 빅테크를 포함해 기타 민간기업과의 협력이 필요하기 때문에 반드시 신뢰를 되찾는 게 필요하다.

이에 국방부와 기업 간 계약 체결 책임을 맡은 국방혁신단(Defense Innovation Unit, DIU)은 투명성 제고 차원에서 이른바 ‘책임 있는 인공지능’ 가이드라인을 공개했다. 앞으로 제3의 개발사가 인사 시스템이건 공격 목표물 인식이건 군용 AI를 구축할 때 이 가이드라인을 따라야 한다.