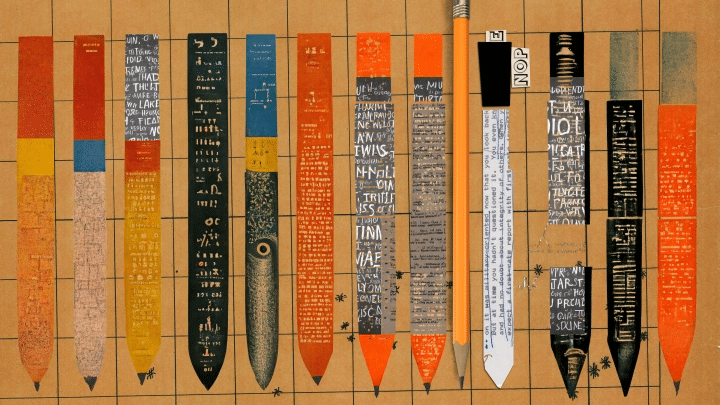

STEPHANIE ARNETT/MITTR

How AI-generated text is poisoning the internet

AI가 쓴 글이 인터넷을 오염시키고 있다

AI 언어 모델들은 인터넷에 있는 글들을 수집하고 추출하여 문장을 만들어내지만, 이 과정에서 유해하고 악의적이거나 거짓된 정보들이 걸러지지 않은 채 그대로 포함되고 또 다른 문장을 만드는 데 재활용되면서 잘못되거나 질이 낮은 정보들이 끊임없이 확산된다.

2022년은 AI에게 다사다난한 해였다. 인터넷을 자주 사용하는 사람이라면 아마도 DALL-E 2나 스테이블 디퓨전(Stable Diffusion)과 같은 AI 시스템이 생성한 이미지나 오픈AI(OpenAI)의 대형 언어 모델 GPT-3의 최신 버전으로 여겨지는 챗GPT(ChatGPT)가 작성한 농담, 에세이 등의 글들을 마주친 경험이 있을 것이다.

어떤 경우에는 AI에 의해 생성된 그림이나 문장들을 분명히 알아볼 수 있다. 그러나 이러한 AI 모델들이 만들어내는 결과물이 인간이 만든 창작물로 오인되는 경우가 점차 늘어나고 있다. 특히 대형 언어 모델들은 확신에 찬 헛소리를 생산하는 기계들이다. 대형 언어 모델들은 사실처럼 보이지만 실제로는 거짓이 가득한 글들을 생성할 수 있다.

그저 사소한 장난에 불과하다면 별문제가 되지 않겠지만, AI 모델을 사용하여 검증되지 않은 건강 관련 조언을 제공하거나 다른 형태의 중요 정보를 제공한다면 심각한 피해가 발생할 수 있다. AI 시스템들을 이용하면 각종 잘못된 정보, 욕설 및 스팸을 만들어내는 일이 터무니없을 정도로 쉬워져 우리가 사용하는 정보와 현실감까지 왜곡할 수 있다. 대표적으로, 선거와 관련된 악의적인 사용이 크게 우려된다.