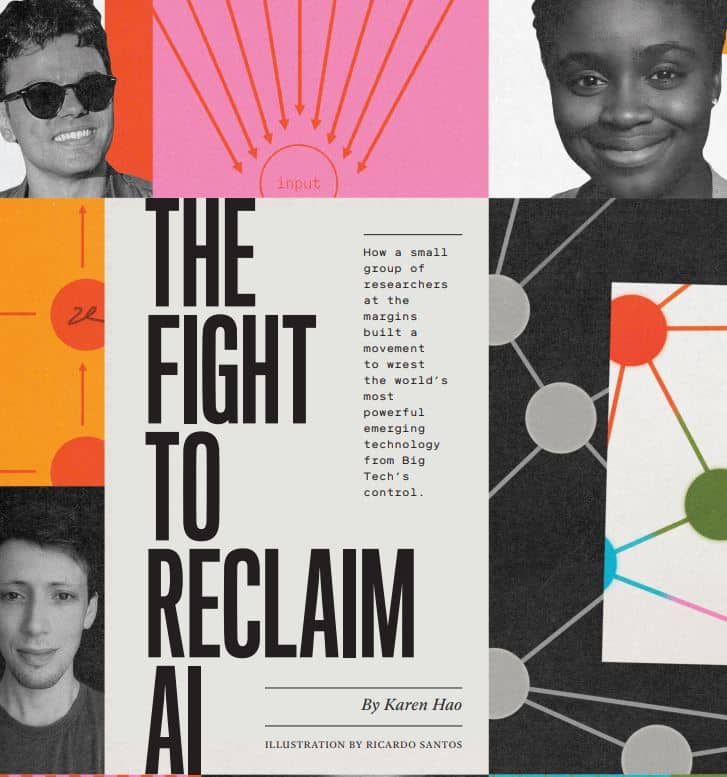

The Fight to Reclaim AI

다윗과 골리앗의 싸움?…빅테크에 맞선 AI 연구원들

인공지능(AI) 연구에 '빅테크'로 불리는 대형 기술 기업들이 뛰어들면서 많은 연구자들이 사회 문제 해결에 도움이 되는 기술보다는 더 많은 수익을 창출할 수 있는 기술 연구에 집중하고 있다. 빅테크 기업들이 AI 분야를 사실상 장악하고 있는 상황에서 기업이 아니라 우리 모두에게 필요한 기술을 개발하기 위해 움직이고 있는 소규모 비주류 연구자들의 노력을 살펴본다

팀닛 게브루(Timnit Gebru)는 한 편의 과학 논문 때문에 자신이 엄청난 곤경에 빠질 것이라고 전혀 예상하지 못했다.

2020년 구글 AI 윤리팀의 공동 책임자였던 게브루는 에밀리 벤더(Emily Bender) 워싱턴 대학교의 언어학 교수에 연락해 함께 인공지능(AI)의 문제점에 대한 공동 연구에 착수했다. 게브루는 최근 AI 연구 분야에서 가장 놀라운 혁신 중 하나로 평가되는 ‘대규모 언어 모델(Large language model)’이 초래할 수 있는 위험을 구체적으로 파악하고 싶었다. 대규모 언어 모델이란 엄청난 양의 텍스트를 학습하도록 훈련된 알고리즘을 말한다. 적당한 조건이 갖춰친 상태에선 이 모델은 사람이 쓴 것 같은 복잡한 문장을 생성해낼 수 있다. 사람과 같이 기사를 쓰거나 대화를 자연스럽게 이어 나가는 서비스가 대표적인 대규모 언어 모델에 기반한 AI 서비스들이다.

지난 몇 년 동안 기술 기업들은 더 거대한 언어 모델을 구축하여 제품 판매에 활용하기 위해 경쟁해왔다. 본 기술을 개발한 구글은 이를 통해 검색 엔진의 성능을 개선해오고 있었다. 또 인공지능 연구소인 오픈AI(OpenAI)는 2020년 6월에 ‘GPT-3’라는 최대 규모의 언어 모델을 발표하고 몇 달 뒤 마이크로소프트에 GPT-3 독점 사용권을 부여했다.